强化学习训练DQN模型

训练模型的时候发现训练越长时间,反而效果不好。

训练了8小时的DQN架构的模型比不过4小时的,有哪位资深博主能解释一下吗?

- 你看下这篇博客吧, 应该有用👉 :麻雀虽小,五脏俱全,100行代码实现最简单的DQN

- 除此之外, 这篇博客: 从零搭建强化学习DQN框架中的 训练效果展示 部分也许能够解决你的问题, 你可以仔细阅读以下内容或者直接跳转源博客中阅读:

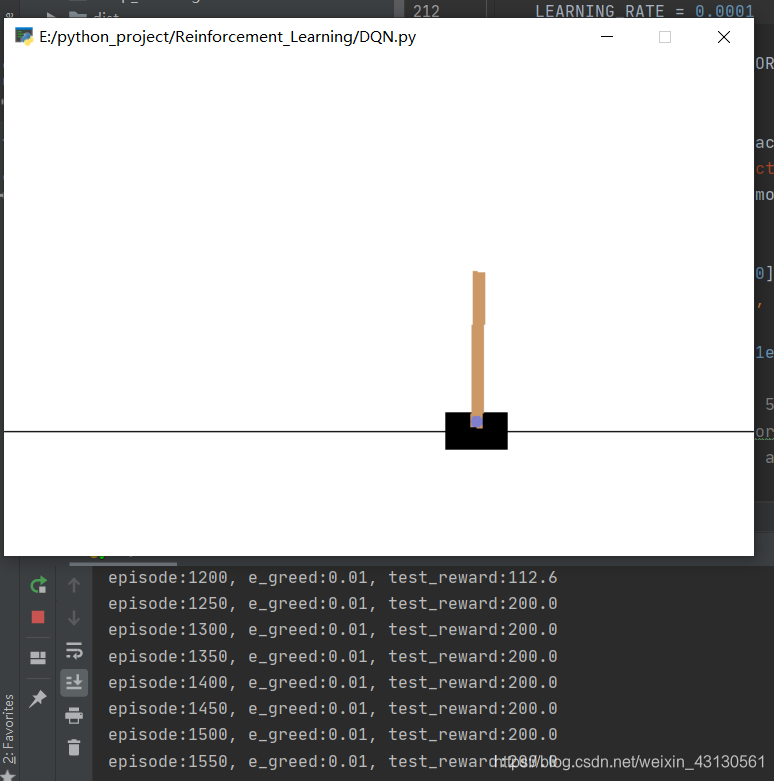

训练一段时间之后,test_reward可以达到200分,此时倒立摆可以稳定地束起来(读者可以自行调节learning_rate,网络模型查看不同效果) - 以下回答来自chatgpt:

问题的现象是训练时间越长,模型的效果反而越差。这可能是由于以下原因导致的:

过拟合:训练时间长可能导致模型在训练数据上过度拟合,使得在新的数据上表现差。可以通过增加数据集的多样性,增加正则化惩罚项,或使用早停策略等方式来减少过拟合。

学习率设置不合适:学习率过大可能导致模型在训练过程中收敛不稳定,学习率过小可能导致收敛过慢。可以尝试调整学习率的大小,或使用自适应学习率的优化算法,如Adam。

DQN架构的不稳定性:DQN算法本身存在训练不稳定的问题,表现为训练开始时,模型的效果会很差,然后逐渐收敛。可以尝试使用经验回放、目标网络等方法来缓解这个问题。

模型的超参数选择:模型的超参数选择可能会影响模型的性能,如网络结构、训练参数等。可以尝试调整超参数的选择,比如调整神经网络的层数、神经元个数等。

综上所述,可以尝试以下解决方案来解决该问题:

增加训练数据的多样性,如通过引入不同的游戏状态、调整游戏环境等来增加多样性。

调整学习率的大小,可以尝试使用自适应学习率的优化算法,如Adam。

使用经验回放和目标网络等方法来缓解DQN算法的不稳定性问题。

调整模型的超参数选择,可以尝试调整神经网络的层数、神经元个数等。

如果以上方法都不能解决问题,可能需要进一步分析模型训练过程中的其他因素,比如数据预处理、网络结构等,或者考虑尝试其他的强化学习算法。

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^

时间虽短,但内容精,能把重要点都吸收了。

而训练长可能会使人疲惫,不太想上,而且记忆量又大,谁会记得住呢?