虚拟机里安装好spark后pyspark启动不成功

spark安装成功并且使用spark- shell可以出现图标,但运行bin/pyspark没有出现图标,哪里出问题了,怎么解决求

spark版本是3.4

Hadoop版本是3.3

python版本是3.5

根据您提供的错误信息,看起来是 conf.py 中的 _jconf 定义出现了 SyntaxError 异常。这个问题一般是由于该版本的 Python 不支持此语法而引起的。

在 Python 3.10 版本之后,Optional 类型已经被正式支持,但是在 Python 3.5 中该语法不受支持。因此,您可以尝试将 Python 升级到 3.6 及以上版本,或者手动将代码从 PySpark 3.4 中的 Python 3.10 版本调整为 Python 3.5 所支持的语法。

如果您不想升级 Python 版本,可以考虑使用较旧版本的 PySpark。较旧的版本可能会更适合 Python 3.5,而不需要代码调整。您可以打开 Spark 官方网站并下载以前版本的 PySpark。

希望这些信息能给您带来帮助。如果您有任何疑问,请随时提出。

不知道你这个问题是否已经解决, 如果还没有解决的话:- 这有个类似的问题, 你可以参考下: https://ask.csdn.net/questions/688018

- 这篇博客也不错, 你可以看下pyspark的链式方法调用问题(python写spark没有方法提示)

- 除此之外, 这篇博客: 『pyspark』〇:spark的安装、配置和使用中的 1.5 启动pyspark 部分也许能够解决你的问题, 你可以仔细阅读以下内容或者直接跳转源博客中阅读:

命令行运行pyspark,输出界面如下:

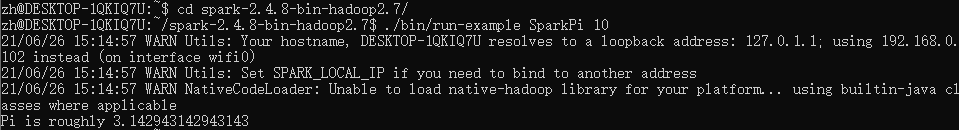

验证Spark是否正常运行:cd ./spark ./bin/run-example SparkPi 10运行之后,输出结果太多,我们还需要配置下环境,降低log4j.properties中log4j记录器的详细级别

cp conf/log4j.properties.template conf/log4j.properties vim conf/log4j.properties打开文件 ‘log4j.properties’ 后,作如下修改:

log4j.rootCategory=INFO, console 替换为 log4j.rootCategory=ERROR, console再次运行

./bin/run-example SparkPi 10可以查看到输出结果:

- 您还可以看一下 尹成老师的python hadoop与spark教程课程中的 spark推荐引擎补充小节, 巩固相关知识点

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^