YOLOv5训练结果有一项一直为0

用YOLOv5做目标检测,检测什么的都很好,但是训练结果图里的cls_loss一直为0,是哪里有什么问题吗 求解答

显卡什么版本,GTX16XX系列的出现过这种error,要是你遇到这个问题把cuda换为10.2的版本

你需要在测试一下训练出的网络模型,提醒下这种问题没有决定性答复,有时候训练参数调整了也会修复问题

该回答通过自己思路及引用到GPTᴼᴾᴱᴺᴬᴵ搜索,得到内容具体如下:

在YOLOv5中,cls_loss表示分类损失,如果在训练过程中cls_loss一直为0,可能会有以下几个原因:

数据集类别过少:如果训练数据集中只有一个类别,那么分类损失就会一直为0。在训练过程中,应该确保数据集中包含多个类别的目标,以便训练模型的分类能力。

学习率设置过大或过小:学习率设置过大或过小会影响训练过程中的分类损失。如果学习率设置过大,会导致模型无法收敛,分类损失一直为0;如果学习率设置过小,会导致模型收敛速度很慢,分类损失也可能会很小。建议根据具体情况调整学习率,以便训练出更好的模型。

模型结构问题:如果模型结构问题,可能会导致分类损失一直为0。建议检查模型结构,确保模型的分类能力得到充分的发挥。

训练数据问题:如果训练数据中存在问题,可能会导致分类损失一直为0。建议检查训练数据,确保数据的质量和数量都符合要求。

建议你可以根据以上几个原因逐一排查,确定具体的问题所在,然后进行相应的调整。如果还有疑问,可以查看训练日志,分析模型在训练过程中的表现,以进一步了解问题所在。

如果以上回答对您有所帮助,点击一下采纳该答案~谢谢

以下答案由GPT-3.5大模型与博主波罗歌共同编写:

在YOLOv5中,cls_loss衡量的是分类的损失,如果你的训练结果图里的cls_loss一直为0,则意味着模型分类的损失很小或者没有分类损失。这个问题可能是由于以下原因导致的:

数据集类别过于单一

这种情况通常发生在数据集中只包含一个物体类别的情况下,这导致模型无法进行分类损失的训练。为了解决这个问题,你需要使用一个包含不同种类物体的数据集。样本类别不平衡

这种情况通常发生在数据集中某些物体类别的数量比其他类别要多或者少,这会导致模型在分类时不同类别的表现不平衡。为了解决这个问题,你可以使用平衡采样、加权损失等方法来平衡样本类别。损失函数的设定不正确

在一些情况下,模型可能会收敛到一个错误的局部最小值,这是由于损失函数没有正确设定导致的。为了解决这个问题,你需要仔细检查损失函数,确保其正确反映了你的任务需求。

下面给出一个简单的YOLOv5代码供参考:

# 导入必要的库

import torch

from torch.utils.data import DataLoader

from torchvision import transforms

from models import *

from dataset import *

# 配置文件

cfg = {

'num_classes': 2, # 类别数

'img_size': 416, # 输入图片大小

'batch_size': 16, # 批次大小

'epoches': 30, # 训练轮数

'lr': 0.001, # 学习率

'device': 'cuda' # 训练设备

}

# 数据集

train_transforms = transforms.Compose([

transforms.Resize((cfg['img_size'], cfg['img_size'])),

transforms.RandomHorizontalFlip(),

transforms.ToTensor(),

])

test_transforms = transforms.Compose([

transforms.Resize((cfg['img_size'], cfg['img_size'])),

transforms.ToTensor(),

])

train_dataset = MyDataset('train.txt', transform=train_transforms)

test_dataset = MyDataset('test.txt', transform=test_transforms)

train_dataloader = DataLoader(train_dataset, batch_size=cfg['batch_size'], shuffle=True)

test_dataloader = DataLoader(test_dataset, batch_size=cfg['batch_size'], shuffle=False)

# 模型

model = YOLOv5(cfg)

# 优化器

optimizer = torch.optim.Adam(model.parameters(), lr=cfg['lr'])

# 学习率调整

scheduler = torch.optim.lr_scheduler.StepLR(optimizer, step_size=10, gamma=0.1)

# 损失函数

criterion = YOLOv5Loss(cfg)

# 训练

model.to(cfg['device'])

for epoch in range(cfg['epoches']):

model.train()

for i, (images, targets) in enumerate(train_dataloader):

images = images.to(cfg['device'])

targets = [target.to(cfg['device']) for target in targets]

optimizer.zero_grad()

outputs = model(images)

loss = criterion(outputs, targets)

loss.backward()

optimizer.step()

if (i + 1) % 10 == 0:

print('Epoch [{}/{}], Step [{}/{}], Loss: {:.4f}'.format(

epoch+1, cfg['epoches'], i+1, len(train_dataloader), loss.item()))

# Test the model

model.eval()

with torch.no_grad():

total_loss = 0

for images, targets in test_dataloader:

images = images.to(cfg['device'])

targets = [target.to(cfg['device']) for target in targets]

outputs = model(images)

loss = criterion(outputs, targets)

total_loss += loss.item()

avg_loss = total_loss / len(test_dataloader)

# 更新学习率

scheduler.step()

print('Epoch [{}/{}], Loss: {:.4f}'.format(epoch+1, cfg['epoches'], avg_loss))

如果我的回答解决了您的问题,请采纳!

- 这个问题的回答你可以参考下: https://ask.csdn.net/questions/7746915

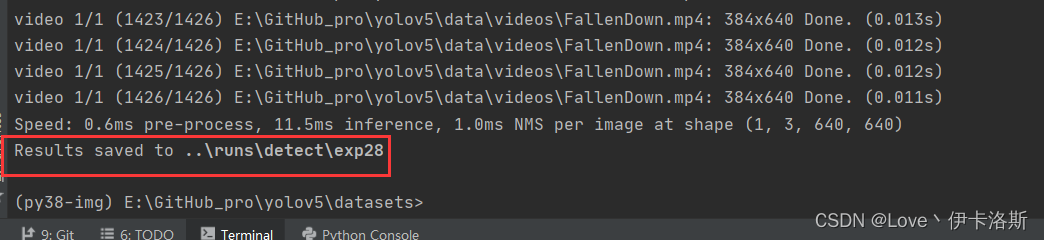

- 除此之外, 这篇博客: YOLOV5 环境搭建和使用记录中的 找个视频识别下 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

python ..\detect.py --weights ..\runs\train\ikaros\ikaros.pt --source ..\data\videos\FallenDown.mp4