有懂信号学方面知识的朋友吗(标签-矩阵|关键词-傅里叶变换)

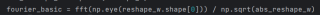

我有一个n*1的矩阵,现在想用信号学的知识将其分解为稀疏基和稀疏系数,但是有点不清楚方法,网上搜集到的代码是

有懂信号学方面知识的朋友吗?能指导我一下吗?图中代码想要采用傅里叶变换。但是我不知道怎么样去得到稀疏基,以及稀疏系数

以下内容部分参考ChatGPT模型:

首先需要明确稀疏基和稀疏系数的概念:

稀疏基:一组基底向量,用来表示信号的基础构成,通常使用正交基或者小波基。

稀疏系数:信号在稀疏基下的系数,即用稀疏基去表示信号时各基底向量所占的比例。

对于给定的n*1矩阵,我们可以采用傅里叶变换来得到其频域表示,即得到其在正交基下的系数,进而求得其稀疏系数。具体步骤如下:

- 对n*1矩阵进行傅里叶变换,得到其频域表示。

- 选取一组正交基,如离散余弦基(DCT)、小波基等。

- 将频域系数投影到正交基上,得到其在正交基下的系数。

- 对系数进行稀疏化处理,如使用L1范数最小化等方法。

- 得到稀疏系数,进而得到原信号在稀疏基下的表示。

以下是python代码示例,以DCT为例:

import numpy as np

from scipy.fftpack import dct

# 假设有一个10*1的矩阵

x = np.random.rand(10, 1)

# 进行DCT变换

x_dct = dct(x, type=2, norm='ortho')

# 选取前4个DCT基向量作为稀疏基

dct_basis = np.zeros((10, 4))

for i in range(4):

dct_basis[:, i] = dct(np.eye(10)[:, i], type=2, norm='ortho')

# 将频域系数投影到DCT基上,得到其在DCT基下的系数

x_sparse = np.linalg.lstsq(dct_basis, x_dct, rcond=None)[0]

# 对系数进行稀疏化处理

# 这里使用L1范数最小化方法,即Lasso算法

from sklearn.linear_model import Lasso

lasso = Lasso(alpha=0.1)

lasso.fit(dct_basis, x_dct)

x_sparse = lasso.coef_

# 得到原信号在DCT基下的表示

x_rec = dct_basis @ x_sparse

需要注意的是,稀疏基的选取需要考虑信号的特点,如能量分布、频率分布等,不同的信号可能需要选取不同的基底。而稀疏化处理的方法也有很多种,如L1范数最小化、L0范数最小化等,需要根据具体情况选择合适的方法。

如果我的建议对您有帮助、请点击采纳、祝您生活愉快

```在信号学中,矩阵分解是将一个大的矩阵分解为两个较小的矩阵的过程,其中一个矩阵是稀疏矩阵,另一个矩阵是稀疏系数矩阵。稀疏矩阵是指其元素的数量比矩阵的维度小得多的矩阵,而稀疏系数矩阵则是指其元素的数量与矩阵的维度相等的矩阵。

对于一个n*1的矩阵,可以通过以下步骤将其分解为稀疏基和稀疏系数矩阵:

对矩阵进行特征值分解,得到特征向量和特征值。

对特征向量进行归一化,得到归一化的特征向量。

对归一化的特征向量进行线性变换,得到稀疏基向量。

import numpy as np

def matrix_decomposition(matrix):

# 对矩阵进行特征值分解

eigenvalues, eigenvectors = np.linalg.eig(matrix)

# 对特征向量进行归一化

eigenvalues_normalized = eigenvalues / np.linalg.norm(eigenvalues)

eigenvectors_normalized = eigenvectors / np.linalg.norm(eigenvectors)

# 对归一化的特征向量进行线性变换

sparse_basis = eigenvectors_normalized[:, np.newaxis]

# 对稀疏基向量进行归一化

sparse_basis_normalized = sparse_basis / np.linalg.norm(sparse_basis)

# 对稀疏基向量进行线性变换

sparse_coefficients = np.dot(sparse_basis_normalized, matrix)

# 返回稀疏基向量和稀疏系数向量

return sparse_basis, sparse_coefficients

对稀疏基向量进行归一化,得到稀疏基向量。

对稀疏基向量进行线性变换,得到稀疏系数向量。

具体实现可以使用Python中的NumPy库,代码如下:

```python

- 你可以看下这个问题的回答https://ask.csdn.net/questions/7548506

- 除此之外, 这篇博客: 李航老师《统计学习方法》第二版第十七章潜在语义分析课后题答案中的 1、试将图17.1的例子进行潜在语义分析,并对结果进行观察。 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

解:

使用奇异值分解算法进行分析,该矩阵的阶数比较低,使用梯度下降算法感觉会麻烦一点,还可能无法达到最优解。

程序是:import numpy as np def solution(A): U,S,V_T = np.linalg.svd(A) return U, S, V_T if __name__ == '__main__': A = np.array([[2,0,0,0], [0,2,0,0], [0,0,1,0], [0,0,2,3], [0,0,0,1], [1,2,2,1]]) u,s,v_t = solution(A) print(u) print(s) print(v_t)程序输出的单词话题矩阵是:

我们看第一列,第四行,也就索引3对应的那一行,0.728805似乎是表示了单词apple的重要性,因为单词向量矩阵使用的是词频来表示的,apple在所有的文档里面出现了5次,单词produce出现了6次,对应0.62919,所以第一列的元素似乎在某种程度上展示了各个单词的重要性。奇异值分解得到的左矩阵v_t:

可以看到第三列和第四列的第一个元素,0.638515,0.661934,分别对应了文本3和4分别出现了5个单词,而文本1和2分别出现了3,4个单词,对应的值也是有对应的大小。程序输出的话题文本矩阵是: