scrapy项目中找不到xpath属性

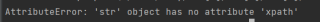

在我运行scrapy项目时经常出现xpath无法使用(如以下情况)

在网上找问题说是extract/extract_frist导致的问题,但我除去该函数还是报错,求解答

节点是none吧,你看你解析的节点,存不存在?不存在他也会报这个错误

这个错误通常发生在尝试使用 XPath 选择器解析一个字符串对象时。常见的情况是在编写 Scrapy 爬虫时,在解析 HTML 页面时,可能会错误地将字符串对象传递给了 response.xpath() 方法,而不是 Scrapy 的 Selector 对象。

要解决这个问题,需要确保 response 是一个 Scrapy 的 Response 对象,可以通过在爬虫代码中添加调试信息来识别问题的来源。下面是几种可能的情况和解决方法:

如果在 Scrapy 爬虫的回调函数中出现这个错误,可以检查 response 是否正确赋值。通常情况下,可以使用 Scrapy 提供的 response.css() 或 response.xpath() 方法选择页面元素。例如:

def parse(self, response):

# 使用 css 选择器获取页面元素

title = response.css('h1::text').get()

如果在爬虫代码中使用字符串对象而不是 Response 对象,则需要使用 Scrapy 的 TextResponse 或 HtmlResponse 对象将字符串包装成响应对象,以便后续使用。例如:

from scrapy.http import TextResponse

# 将字符串对象包装成 TextResponse 对象

response = TextResponse(url='http://example.com', body='<html><body><h1>Hello, World!</h1></body></html>')

title = response.xpath('//h1/text()').get()

如果在使用 Scrapy 的 FormRequest 或 Request 对象时出现这个错误,可以检查请求是否正确构造。可以通过 Request(url=url, callback=callback_func) 方法发送 GET 请求,或者使用 FormRequest(url=url, formdata=form_data, callback=callback_func) 方法发送 POST 请求。例如:

from scrapy import Request

# 发送 GET 请求

yield Request(url='http://example.com', callback=self.parse)

# 发送 POST 请求

form_data = {'name': 'John', 'age': '30'}

yield FormRequest(url='http://example.com/submit', formdata=form_data, callback=self.parse)

通过这些方法,应该可以解决出现 AttributeError: 'str' object has no attribute 'xpath' 的问题。