用tensorflow做梯度下降

这是鸢尾花种类判别,感觉挺经典的,

for epoch in range(epoch): #数据集级别的循环,每个epoch循环一次数据集

for step, (x_train, y_train) in enumerate(train_db): #batch级别的循环 ,每个step循环一个batch

with tf.GradientTape() as tape: # with结构记录梯度信息

y = tf.matmul(x_train, w1) + b1 # 神经网络乘加运算

y = tf.nn.softmax(y) # 使输出y符合概率分布(此操作后与独热码同量级,可相减求loss)

y_ = tf.one_hot(y_train, depth=3) # 将标签值转换为独热码格式,方便计算loss和accuracy

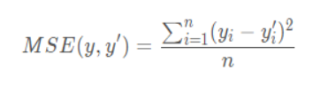

loss = tf.reduce_mean(tf.square(y_ - y)) # 采用均方误差损失函数mse = mean(sum(y-out)^2)

loss_all += loss.numpy() # 将每个step计算出的loss累加,为后续求loss平均值提供数据,这样计算的loss更准确

如果仅仅是做预测,我知道要把预测值经过softmax,这样就能得到各个种类可能的预测概率,单独的one_hot我也明白,但是上面这个代码,做损失函数,为啥预测值要经过softmax,真实值要经过one_hot,这两个相加减我不是很明白,为啥这样计算损失函数

以使网络模型更快地输出优质的 one-hot 编码 ->这个说的更明显http://t.csdn.cn/DzXTX ,但总的意思就是为加快网络输出结果尽快向 one-hot 编码收敛需要做一个变幻,变换称为 softmax 函数,这样yi就有了,然后用均方差损失函数来求一个损失值

- 这篇文章:TensorFlow实现梯度下降 也许有你想要的答案,你可以看看