h5py报错:FileNotFoundErr

#使用h5py读取h5文件时,报错

FileNotFoundError: [Errno 2] Unable to open file (unable to open file: name = './datasets/train_catvnoncat.h5', errno = 2, error message = 'No such file or directory', flags = 0, o_flags = 0)

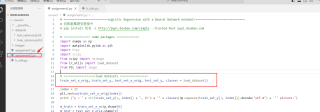

我是在assignment2.py中调用lr_utils.py中的load_dataset

向GPT提问也没找到错误:

非常抱歉,我之前的回答可能引起了误解。如果 train_catvnoncat.h5 的父目录与代码所在的文件处于同一目录,那么相对路径 ./datasets/train_catvnoncat.h5 理应是正确的。

在这种情况下,如果您仍然遇到 "FileNotFoundError" 错误,那么建议您检查以下几点:

文件名和路径拼写: 请再次仔细检查文件名和路径的拼写。确保没有多余的空格或拼写错误。

文件存在性: 使用文件浏览器或命令行,确认

train_catvnoncat.h5文件确实存在于父目录中。文件权限: 确保您具有足够的权限来读取

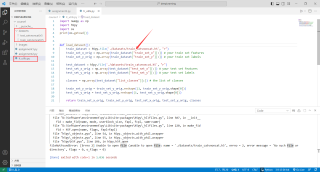

train_catvnoncat.h5文件。有时权限问题可能导致文件无法被读取。工作目录问题: 在某些情况下,代码的当前工作目录可能与您期望的不同。您可以通过添加一行代码来检查当前工作目录:

import os print(os.getcwd())确保工作目录与您期望的位置一致。

其他因素: 某些情况下,可能存在一些不常见的因素,例如操作系统特定的问题。您可以尝试在不同的系统和环境中运行代码,看看问题是否仍然存在。

如果您排除了上述所有情况,问题仍然存在,您可以尝试在代码中使用绝对路径来打开文件,这将绕过任何路径解析的问题。例如:

import h5py

file_path = "/绝对路径/to/your/parent/directory/train_catvnoncat.h5"

train_dataset = h5py.File(file_path, "r")

最后,如果问题仍然无法解决,可能需要更多的上下文信息才能深入分析问题。

【以下回答由 GPT 生成】

由于您提供的信息有限,我将给出一些可能的解决方案来帮助您解决问题。

- 检查文件名的拼写和大小写

首先,请确保在文件路径中正确拼写文件名,并注意大小写,以防在命名文件或路径时存在错误。

检查文件的权限

确保您具有读取train_catvnoncat.h5文件的权限。可以尝试更改文件的权限,以便您可以读取它。可以使用

chmod命令更改文件的权限:bash chmod +r train_catvnoncat.h5确认文件是否存在

- 确保train_catvnoncat.h5文件确实存在于当前目录中。您可以使用以下代码片段来验证文件的存在性: ```python import os

file_path = './datasets/train_catvnoncat.h5' if os.path.isfile(file_path): print("文件存在") else: print("文件不存在") ```

- 检查工作目录

- 在尝试打开文件之前,确认您的当前工作目录与您期望的工作目录一致。您可以使用以下代码片段来验证当前工作目录: ```python import os

print(os.getcwd()) ```

- 尝试使用绝对路径

- 如果在相同目录下仍然无法找到文件,您可以尝试使用文件的绝对路径来打开文件。您可以使用以下代码片段来获取文件的绝对路径: ```python import os

file_path = os.path.abspath('./datasets/train_catvnoncat.h5') train_dataset = h5py.File(file_path, 'r') ```

- 在不同的系统和环境中运行代码

- 如果您在本地环境中遇到此错误,请尝试在另一个系统或环境中运行代码,看看问题是否仍然存在。这有助于确定问题是否与特定环境相关。

如果您尝试了以上解决方案后问题仍然存在,请提供更多详情,例如完整的代码和环境信息,以便我能够更好地帮助您解决问题。

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^