下面的压缩方法是否可行

我想出一种新的数据压缩方式,不知道是不是可行,所以请各位测试一下,以下的压缩方法是否可行。

优点;分组、随机删除,多次压缩,可以逐步提高压缩比

缺点:随机删除,压缩效果难控制和预测,估计达不到你的所谓预期,中间如果出错或者损坏原因很难找到

多次压缩,得到指定的压缩比?这个似乎不太现实。压缩比和你的数据熵有关,高熵数据是不可能无限压缩的。

不行,文件大小都不一样

这都是纸上谈兵

你先随便造一段数据,用你自己的办法压缩一下,看压缩比到底是多少,是能无限压缩的吗

然后再解压缩看看能还原吗

实际测试一下就知道到底哪里有问题了

你只要实际测试过,立即就能知道它到底能不能工作

即使别人都告诉你不能,但是你知道事实上它是能工作的

而你没测试过,老想听别人的意见,只会把你带沟里去

我经常告诉别人,在问为什么之前,先问问是什么

是什么就不用别人告诉你了,你自己测试一下最准确,最好不要用纸笔计算而是写成代码,这样不会人为原因出错

等测试结果出来了,不理解它为什么不行,或者它为什么能行,再问

压缩比不是你想要就能达到的

多次压缩,得到指定的压缩比?这个似乎不太现实。压缩比和你的数据熵有关,高熵数据是不可能无限压缩的。

如果你真的要搞压缩算法,就把自己的算法写成程序,实际测试下,可行与否完全可以自己判断了。空谈误国。

我有个压缩比更高的方案:数据转成二进制,计算这段二进制出现在圆周率(二进制)的第x位开始,第y位结束。(圆周率大概率是正规数,所以一定存在x,y)

这样任何数据都可以压缩为两个数字。

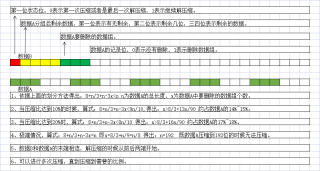

根据提供的图片,您尝试提出了一种新的数据压缩方法,并希望验证其可行性。然而,仅凭一张图片无法提供足够的信息来评估该方法的有效性。为了能够更好地帮助您,我需要详细了解您的压缩方法的原理和实施细节。

请提供以下信息来描述您的数据压缩方法:

- 压缩原理:请解释您的压缩方法的原理,包括如何减小数据的大小和还原数据的过程。

- 压缩算法:说明您使用的具体压缩算法或技术。例如,是基于无损压缩还是有损压缩?采用了哪些压缩算法或编码方式?

- 实施细节:提供有关如何实施该方法的详细信息。例如,是否需要特定的编程技术或库?是否有特定的解压缩步骤?

提供上述信息后,我将尽力评估您的压缩方法的可行性,并给出相关的建议或意见。

实践是检验真理的唯一标准,这个方法要是可行早就有人弄了,多次压缩,压缩后的文件大小不一定会继续变小,甚至可能会变大。这是因为每次压缩都会使数据失去一些信息,如果压缩多次,数据的信息量会越来越少,导致压缩后的文件大小不再减小,甚至变大。