改进WGAN跑64的和128的效果不一样?!

改进后的Wgan生成64的效果还可以,生成128的100个epoch后模式崩溃了,为什么啊?

这个和你的数据量,参数数量,模型都有关系。崩溃看看错误信息,是不是爆了内存缓存。

加一下更多的训练时间,和适合128像素图像的模型结构。

可能是因为生成128的模型更加复杂,需要更长的训练时间和更大的训练数据集。您可以尝试增加训练数据集的大小,或者增加训练时间,看看是否能够改善模型的效果。此外,您还可以尝试使用其他的生成模型,例如DCGAN或者PGGAN,看看是否能够得到更好的结果。

训练过程中,模型需要学习更多的特征,并在生成更大的图像时保持稳定性和一致性。可以尝试使用更大的Batch Size、更小的学习率、更多的训练数据,或者重新构建模型架构来改进生成128的效果。

模式崩溃是指生成器开始生成相似或重复的图像,而不是多样性丰富的图像。这可能是由多种原因导致的,以下是一些建议和可能的原因:

训练不足:生成128x128分辨率的图像需要更多的训练时间和更复杂的模型。100个epoch可能不足以让模型收敛。尝试增加训练epoch数,以便模型有更多的时间学习生成高质量的128x128图像。

模型容量:生成更高分辨率的图像可能需要更大的模型容量。尝试增加生成器和判别器的层数和神经元数量,以便模型能够捕捉更多的图像细节。

学习率:不同分辨率的图像可能需要不同的学习率。尝试调整学习率,以找到适合生成128x128图像的最佳值。

损失函数:WGAN使用Wasserstein距离作为损失函数,但在某些情况下,这可能不是最佳选择。尝试使用其他损失函数,如LSGAN(Least Squares GAN)或HINGEGAN(Hinge GAN),以改善生成128x128图像的性能。

数据集:确保您的数据集包含足够多样性的128x128图像。如果数据集中的图像过于相似,模型可能会学习生成重复的图像。

正则化:在训练过程中添加正则化项,如权重衰减或梯度惩罚,可以帮助防止模式崩溃。

使用更先进的GAN架构:尝试使用更先进的GAN架构,如ProGAN、StyleGAN或BigGAN,这些架构在生成高分辨率图像方面表现更好。

总之,生成128x128分辨率的图像可能需要更多的训练时间、更大的模型容量和不同的超参数设置。尝试调整这些参数,并考虑使用更先进的GAN架构,以改善生成128x128图像的性能。

- 给你找了一篇非常好的博客,你可以看看是否有帮助,链接:WGAN的来龙去脉

- 除此之外, 这篇博客: 使用残差网络与wgan制作二次元人物头像:训练过程详解中的 一批次的图像 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

前面的参数调式的时候查看一下就行,这里有几个重要的参数需要记录一下。

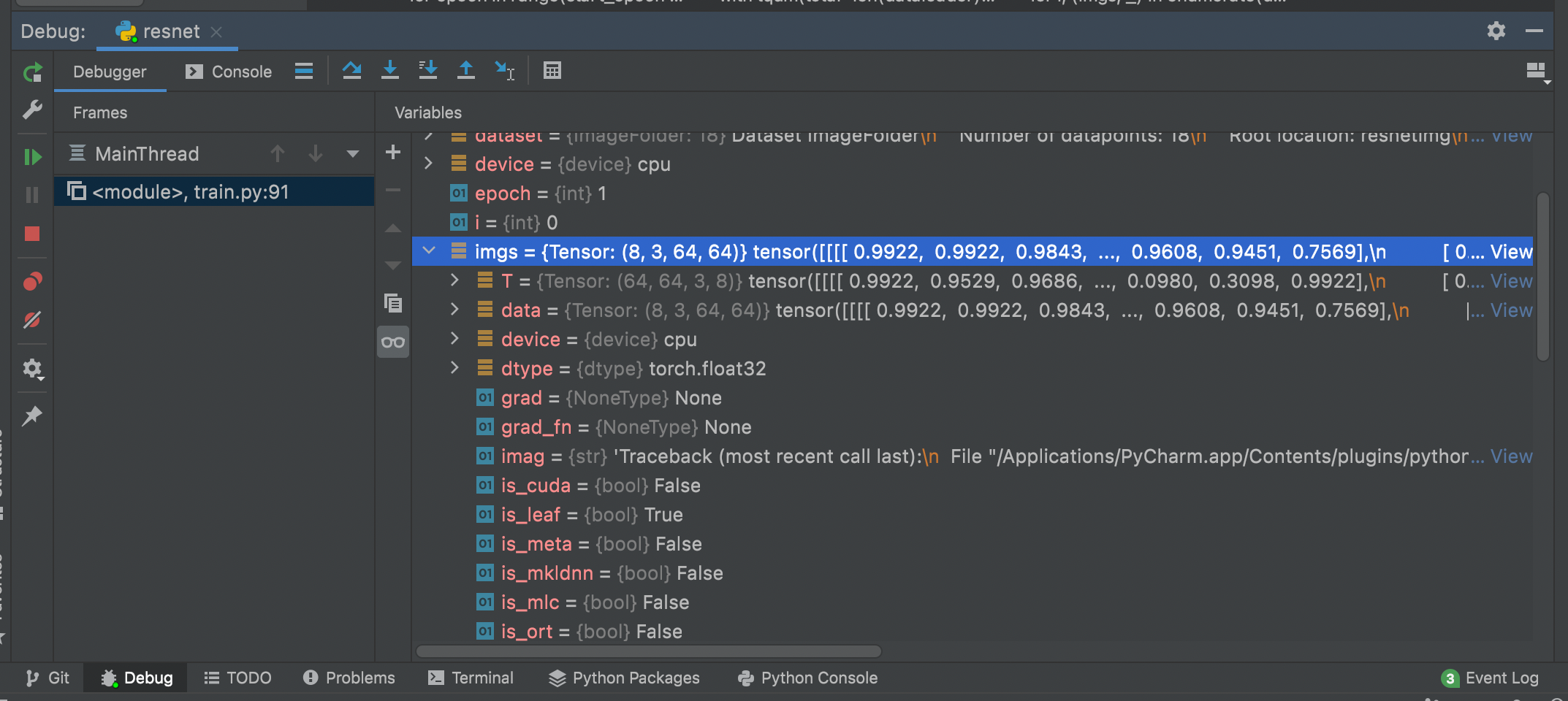

imgs = (8, 3, 64, 64)把这一批次的图像送进D网络,D网络会输出一个二维的数组。

通过你提供的信息较少,我无法确定导致这种行为的确切原因。WGAN的稳定性是其成功的一个关键因素,但是在生成器和判别器之间使用的距离度量和一些训练细节也可能会影响模型的稳定性。

以下是您可以尝试的步骤:

1. 确保使用正确的超参数和优化器配置。特别地,盈余系数超参数λ应足够大,以确保判别器的梯度下降速度快于生成器。

2. 启动训练过程并跟踪每个epoch的损失和分布。模式瘫痪可能表现为异常的生成器损失,或者鉴别器区域的垂直梯度(超出标准范围)。确保在每个epoch末尾使用测试集评估生成的图像。

3. 对于128 * 128的图像生成,可以尝试降低初始学习率和梯度裁剪的阈值,这将有助于增加训练的稳定性。

4. 考虑加入额外的正则化(term),如权重衰减或Dropout,以帮助控制模型的复杂性和防止过拟合。

代码也可以提供更多有关模型配置的信息,但这需要更多的上下文和更多详细的描述。同时,针对不同的问题,不同的网络结构更适合,需要您根据您的实际情况进行调整。