深度可分离卷积深度可分离卷积可以减少参数量和计算量;但是使用卷积核为1的卷积,用深度可分离卷积替换原来的卷积,参数量和计算量反而会增加

深度可分离卷积

深度可分离卷积可以减少参数量和计算量,但是如果我的卷积核本身就是1,那使用深度可分离卷积替换原来的卷积,参数量和计算量反而会增加,是这个么个道理吗?我用程序跑出来的结果也确实是这样子,参数量反而会变大

是的,深度可分离卷积确实会增加参数量和计算量。当你使用深度可分离卷积时,你需要将卷积核的参数量增加一倍,因为你需要将卷积核的参数量从1个增加到2个。此外,深度可分离卷积还需要额外的计算步骤来计算卷积结果,这也会增加计算量。

然而,如果你的卷积核本身就是1,那么使用深度可分离卷积替换原来的卷积,参数量和计算量反而会减少,这是因为深度可分离卷积可以减少参数量和计算量,但是它并不能完全替代原来的卷积。在这种情况下,你需要根据具体情况来选择是否使用深度可分离卷积。

总之,深度可分离卷积可以减少参数量和计算量,但是它并不能完全替代原来的卷积。在选择是否使用深度可分离卷积时,需要根据具体情况来决定。

不知道你这个问题是否已经解决, 如果还没有解决的话:- 这有个类似的问题, 你可以参考下: https://ask.csdn.net/questions/7482362

- 你也可以参考下这篇文章:标准卷积、深度可分离卷积和分组卷积的参数量与计算量和感受野大小计算

- 除此之外, 这篇博客: 线性回归与逻辑回归的区别中的 这里可能会有疑问,为什么不直接用线性回归的模型来对这种分类问题进行拟合? 部分也许能够解决你的问题, 你可以仔细阅读以下内容或者直接跳转源博客中阅读:

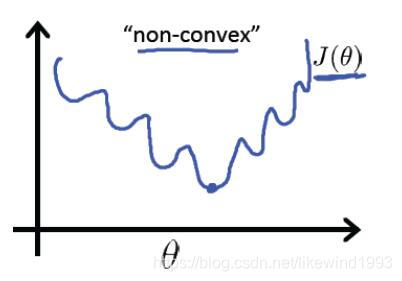

吴恩达的《machine learning》中谈到了这点,线性回归模型的表达能力有限,如果直接使用线性回归,并且使用线性回归的平方和作为成本函数,那么成本函数会变成如下(“non-convex”):

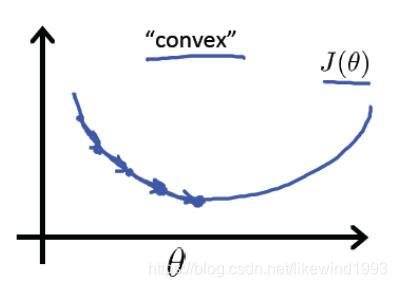

有太多的局部最优解,如果使用逻辑回归并且使用对数损失函数作为成本函数,成本函数才会易于求解(“convex”):

- 您还可以看一下 陈槐老师的零基础新手入门软件测试必知必会课程中的 项目实战中系统编写测试用例有什么意义小节, 巩固相关知识点

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^