TextCNN 反向传播过程速度太慢

利用pytorch写的cnn网络,对文本进行分类,forward过程一般都是几毫秒,而backward过程需要六七十秒,不知道什么原因

以下内容部分参考ChatGPT模型:

可能是由于反向传播中梯度下降算法的迭代次数过多导致速度变慢。可以尝试以下几种方法来优化:

- 减少网络层数和神经元数量,降低模型的复杂度。

- 使用更高效的优化器,如Adam、Adagrad等。

- 减小batch size,加快梯度下降的迭代速度。

- 使用GPU加速计算,提高计算速度。

以下是一些可能有用的代码示例:

使用Adam优化器:

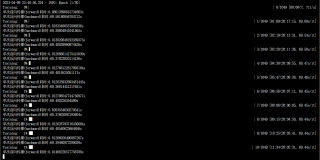

import torch.optim as optim

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

减小batch size:

train_loader = DataLoader(train_data, batch_size=32, shuffle=True)

使用GPU加速计算:

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

# 在训练过程中使用GPU计算

inputs, labels = inputs.to(device), labels.to(device)

如果我的建议对您有帮助、请点击采纳、祝您生活愉快

- 这篇文章:论文复现TextCNN(基于PyTorch) 也许有你想要的答案,你可以看看

- 除此之外, 这篇博客: Pytorch04: 用自己的数据实现TextCNN--基于自定义文本数据处理的一个简单文本分类器中的 一、要实现什么 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

和图像分类相比,文本分类的CNN实现过程有什么不同之处?其实最大的不同就在于如何将文本数据转换成类似图像的二维矩阵以供卷积。

TextCNN的原理可以参考下图。- 最左边能够进行卷积的二维矩阵是由"wait for the video and do n’t rent it"对应的词向量一行一行地拼接来构成的。有关词向量的介绍此处不再赘述,可以查阅关键词进行了解。

- 卷积核的大小和图像卷积核也不同。图像的卷积核一般为正方形,通常为

3*3。但是文本CNN所用的卷积核大小要大得多,通常宽度由词向量的维度数量决定,例如词向量的长度为50时,卷积核的宽就为50,而高度则有三种,即2,3,4,对应形成了三种不同的卷积核。由于卷积核宽度是词向量的长度,因此卷积核移动只能向下移动,卷积的结果就变成了一维的特征向量,而不是图像卷积后的二维特征图。 - 文本CNN中使用的最大池化过程也和图像CNN的不同,它的池化区域不是固定的

2*2区间, 而是整个由卷积得到的向量。也就是说,在文本上进行的一次卷积+池化过程只能得到一个特征值。 - 在原始的TextCNN中,每一种类型的卷积核有两个,经过池化后得到六个特征值,再经过全连接层连接最后的分类输出。然而,一般而言,一种类型的卷积核只用两个效果会没有那么好,建议用多一点,比如

256个,这样全连接层前的特征向量能够长一点。

简单了解了TextCNN的结构,我们就可以知道接下来的工作是干什么了——赶紧把二维矩阵给构建出来吧!