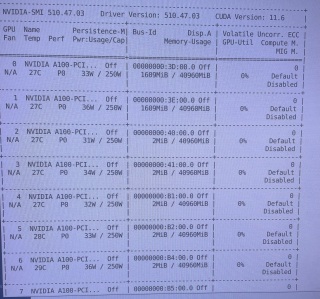

这卡性能可以吗?纯新手入门

因为毕业设计要用到机器学习相关的东西做项目所在地公司据说有显卡,我笔记本的3060估计可以稍一稍了吧

严重怀疑你是来炫耀的,这卡数加显存不起飞了啊

不知道你这个问题是否已经解决, 如果还没有解决的话:- 帮你找了个相似的问题, 你可以看下: https://ask.csdn.net/questions/7446414

- 你也可以参考下这篇文章:【公众号】基于弱监督深度学习的图像分割方法综述

- 除此之外, 这篇博客: 论机器学习中数据的重要性中的 案例研究1:招聘,解雇和刑事司法系统软件 部分也许能够解决你的问题, 你可以仔细阅读以下内容或者直接跳转源博客中阅读:

深度学习算法越来越多地被用于制定影响生命的决策,例如雇用和解雇员工以及刑事司法系统。编码偏差会给决策过程带来陷阱和风险。

COMPAS 再犯算法 ,该算法用于预测囚犯或被控犯罪者如果被释放可能会犯下更多罪行的可能性。该算法用于授予保释,判刑和确定假释。但这个算法在实际使用时,对于白人被告(24%),误报率(标记为“高风险”但未重新犯罪)几乎是黑人被告(错误率45%)的两倍。

种族不是这个算法的明确变量,但种族和性别在很多其他变量中潜伏编码,比如我们居住的地方,我们的社交网络和我们的教育。即使是不注意种族或性别的有意识的努力并不能保证缺乏偏见尽管人们对COMPAS的准确性存有疑虑,但威斯康星州最高法院去年仍坚持使用它。该公司拥有美国80%的警用摄像机市场,因此他们拥有大量的视频数据。此外,新奥尔良警方过去六年一直在使用Palantir的预测性警务软件进行绝密计划,即使是市议会成员也不知道。像这样的应用程序是值得关注的,因为没有透明度。因为这些是私营公司,所以它们不像警察部门那样受制于州/公共记录法。通常,他们在法庭上受到保护,不必透露他们正在做的事情。此外,现有的警方数据存在很多种族偏见,因此这些算法将要从中学习的数据集从一开始就存在偏见。

最后,计算机视觉在实际测试中反复失败,并没有达到应有的效果,无法准确地预测有色人种在未来的犯罪动向,这是一次很失败的机器学习项目投入生产生活实际的例子,由于初始的数据偏见。

- 您还可以看一下 黄菊华老师的完整公司小程序7天从零实战课程(含小程序和后台源代码)【免费40章节】课程中的 微信小程序入门到就业课(全栈课)学习说明【建议看下】小节, 巩固相关知识点

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^