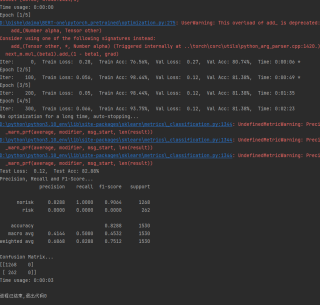

Bert二分类结果分析

大家好,这是我基于pytorch的BERT二分类结果,两个类别分别是norisk(0)和risk(1),在标注的训练数据中,norisk句子的数量比risk句子的数量约为1:4。我使用了FocalLoss,设定的alpha值为0.95,用来改善数据不平衡的情况。

为什么risk类别的预测f1-score仍然为0?是由于什么原因呀?(已经跑了不下7次了,一直都是0,不知道怎么改变)

谢谢解答的朋友!

该回答引用自ChatGPT

有几个可能的原因可以导致risk类别的预测f1-score始终为0:

数据不平衡问题:尽管您使用了Focal Loss来改善数据不平衡问题,但如果risk类别的训练数据量非常少,模型可能仍然无法很好地学习该类别的特征。建议增加risk类别的训练数据量或采用数据增强技术,例如随机替换、删除、插入词汇等。

超参数调节问题:除了alpha值,还有其他超参数需要进行调节,例如学习率、批次大小、隐藏层大小等。建议对这些超参数进行调整并观察结果。

模型结构问题:BERT模型结构非常复杂,需要仔细调整和优化。您可以尝试使用其他的预训练模型,例如RoBERTa、ALBERT等,或者自行调整BERT模型的架构,例如修改隐藏层数、隐藏层大小等。

标签错误问题:最后,也可能是标签错误导致risk类别的预测f1-score为0。建议再次检查标注数据,确保标签正确。

训练集正确率一路飙升,可是验证集没有什么变化,是不是过拟合了。

该回答引用ChatGPT根据您提供的信息,我可以给出以下几点建议:

1. 检查数据集是否存在问题。您可以检查数据集中risk类别的样本是否存在标注错误或者数据质量问题。此外,您也可以尝试使用其他的数据集进行训练,看看是否存在同样的问题。

2. 调整模型参数。您可以尝试调整模型的超参数,例如学习率、batch size等,看看是否能够改善模型的性能。

3. 尝试其他的损失函数。除了Focal Loss,您还可以尝试其他的损失函数,例如Cross Entropy Loss等,看看是否能够改善模型的性能。

4. 尝试其他的模型。除了BERT,您还可以尝试其他的预训练模型,例如RoBERTa、XLNet等,看看是否能够改善模型的性能。

以下是一份可能有用的代码,用于评估模型的性能:

python

import torch

from sklearn.metrics import classification_report

def evaluate(model, dataloader):

model.eval()

y_true = []

y_pred = []

with torch.no_grad():

for batch in dataloader:

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['labels'].to(device)

outputs = model(input_ids, attention_mask)

_, predicted = torch.max(outputs, 1)

y_true.extend(labels.tolist())

y_pred.extend(predicted.tolist())

print(classification_report(y_true, y_pred))

您可以使用该函数来评估模型在验证集上的性能,从而更好地了解模型的表现。