实值特征权重向量和特征选择,多分类

得到的实值的特征权重向量后,选择的特征值是原始样本数据嘛?我的想法是选择原始数据(m维)中对应特征权重向量中权值前n大的n维特征,这样来实现降维却发现效果十分不理想……是我理解错了吗?

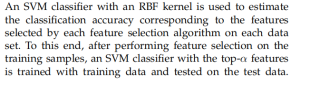

复现的论文是这样的

其中top-alpha,alpha在论文中取值1-30,我认为他就是选择的特征维数,是不是就是把权重向量降序排序排列,然后取前alpha大的权重对应的特征?但输入k近邻分类器之后效果十分不理想……

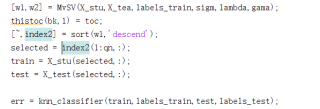

我的代码:

这个实在不行我们就用个1~30进行布长为0.1的遍历,一步步比较答案取最优,最后根据答案进行解释,当然不会解释的话,这么写上去也是可以的,有些时候确实就是这么做的。

该回答引用ChatGPT

请参考,如果可行,还请点击 采纳,感谢!

是的,您的理解是正确的,top-alpha是选择的特征维数,即对权重向量从大到小排序,选择前alpha大的特征。但是降维并不一定能够提高算法的性能,因为可能在降维之后会丢失一些有用的信息。因此,您需要尝试多种降维方法,并选择效果最好的一种。

另外,代码中的第二行有语法错误,应该改为:

[wl,w2] = MvSv(X_stu, X_tea, labels_train, sigm, lambda, gama)

thistoc(bk,1) = toc.

希望对您有所帮助!

不是效果不好,是你没有理解这段话的意思。

这段话说的是,使用带有RBF核的SVM,来估计特征选择算法所选择的特征与分类精度的相关性。具体方法是,先用特征选择算法确定 top-alfa 特征后,再用SVM进行分类。

简单地,每次选择一个特征,用SVM进行分类,得到每个特征与分类精度的相关性,可以用于确定每个特征与分类相关性水平的高低。

进一步地,可以选择组合特征,利用前一步的结果选择 top-alfa 特征,用SVM分类,得到组合特征与分类精度的相关性。

注意,本段话并未提到PCA降维压缩或其它特征提取方法。当然,用 PCA 可以更好地更有效地获得 top-alfa 特征。可以对一种或几种特征选择算法(例如PCA,又如FFT),依次改变 top-alfa 的数量 n,用SVM进行分类,得到对应的分类模型的精度 accr(n),然后研究 accr(n) 的规律。

这些基于实验结果的分析,或者对 accr(n) 曲线的拟合,才是“估计特征选择算法与分类精度的相关性”

- 这有个类似的问题, 你可以参考下: https://ask.csdn.net/questions/7753933

根据您描述以及截图的内容来看,这个特征选择如果选取的并没有将清楚,他只是说了每个数据集都有相应的特征选取算法的,至于说的top-a具体怎么取得,可能你还需要找下资料或者联系下作者,看起来并不是你说的那样排序取top ,而且在强调只取多少个,以达到降维的目的。