这些情绪主播Ai配音用的是谁家的借接口?

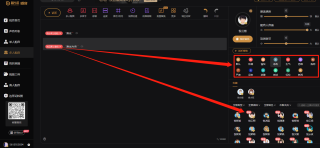

如题,先放几张问题图片

1.悦音配音

2.配音助手App

类似上图这种配音网站或App有很多。他们都有个共同点:那就是里面的部分配音主播是支持(情绪)发音的。

显然,像这种,数百位主播的语音AI合成技术是非常复杂和烧钱的,动辄就是数亿、数十亿元,绝不是这些App的开发者、运营者所能自创的技术服务!因此我断定,他们都是调用了某些大公司的AI合成接口,如:科大讯飞(国内知名度最高),百度云、腾讯云、阿里云AI语音合成 等等。于是,我查了一下科大讯飞的Api文档,而后惊奇的发现,科大讯飞的Api文档中根本就没有(情绪)这项参数!然后我查了百度、腾讯、阿里等Api也都一样,都没有(情绪)这项参数!

这些大厂竟然压根就没有(情绪)主播发音?!惊不惊喜,意不意外,刺不刺激,开不开心?!

尼玛,我好头大!

所以,我的问题是:他们这些App,语音Ai合成用的到底是谁家的技术接口呢?!还是另有玄机,我遗漏了什么?

本人为语音方面的人工智能算法做了4,5年的从业人员,语音合成也就是tts这一块儿现在并没有你想象的那么耗成本,可以说技术已经很成熟了,现在语音合成与语音克隆技术都水平很高了,像ETTS,tacotron2,wavernn,wavegan,deep voice等等。

很多时候只需要采集用户几十条语音就能合成一个差不多的声音,如果需要一个合成效果很完善的声音,那么几百条到上千条也就够了,而像这种有情绪的,无非就是让主播念的时候就带着同一个情绪,几百个主播看起来很多,但是采集这么个数据量并非什么难事,困难的是得到授权,但是其实可以去一些播音学院找些学生,这些人很便宜。

那么现在就差训练了,tts相较于asr训练成本并不高,因为就那么几种声音,数据也不多,当然如果要训得好有一份比较多的数据是肯定的,所以肯定会先购买几份上万条的录音,但是这也不需要太多钱,然后至于gpu,一张v100或者t4的gpu卡绰绰有余。

还有就是这几个网站的试听,实际上都是把他本来录好的一段文字合成效果给你去听,这个效果当然是最好的,如果楼主你多试一些含多音字的句子,你就会发现还是有瑕疵的。

9022年了,github随便搜搜,一抓就一大把开源的,自己丢个语音数据集进去训练一下,不就出结果了么。”数亿、数十亿元“是怎么得出的结论呢?

试试微软的吧,挺符号你的要求的

https://azure.microsoft.com/zh-cn/services/cognitive-services/text-to-speech/#security

你可以百度一下微软TTS,这是我认为做的最牛的、最接近自然人发音的,我猜测这些app应该是用的微软家的。给你甩个链接,你可以体验下,也包含不同情绪的https://azure.microsoft.com/zh-cn/services/cognitive-services/text-to-speech/?speed=0&pitch=0#overview

应该是讯飞