使用Python从网站批量爬取图片并保存到本地时出现了问题

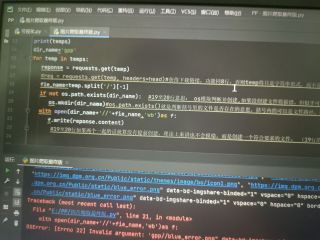

如题,具体情况为前面几张图片保存的都没有什么问题,但是突然到其中一张时就卡壳了,我怀疑是想要保存图片的名字出现了问题。所以我想请教一下有没有什么办法,可以将这一类不符合规范的东西另存起来,或者直接跳过去,最后集中处理。

![TL~U%O]0ET@7BK~O9VUUXFR.jpg img](https://img-mid.csdnimg.cn/release/static/image/mid/ask/648407610926120.jpg?x-oss-process=image/auto-orient,1/resize,w_320,m_lfit)

![R((EMFV(FC~5@1(STUN]IPJ.jpg img](https://img-mid.csdnimg.cn/release/static/image/mid/ask/053437610926192.jpg?x-oss-process=image/auto-orient,1/resize,w_320,m_lfit)

可以把你的程序搞成一个死循环,每开始下载图片就计算时间,执行完下载命令在算一次时间,两次时间做差,当时间大于你估计报错的时间的时候就continue,执行完全部的下载命令后就break,中间出现报错的那些网址你可以全部存入一个列表,到最后统一处理,有用的话点一下采纳