Spark如何剔除“NULL”出现次数大于3的行?

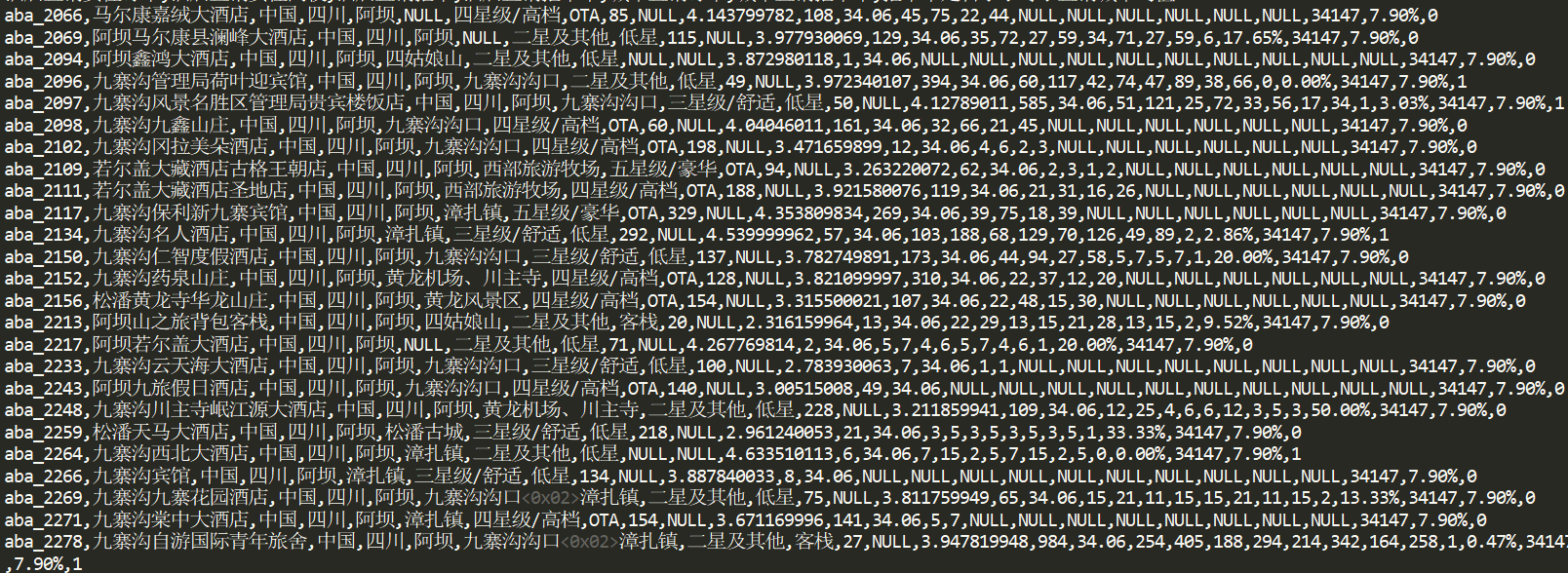

原数据如图。纯新手,最近才接触spark,实在不懂spark的机制,因为在mapreduce里map类里写的每行程序都是针对数据的每一行的,然而spark里textFile读取文件中的每一行后,无论用map还是flatMap遍历后,每行“,”分割的数据都会独立起来,后面filter的操作就没有意义 ,用Java,scala都行

https://blog.csdn.net/mtj66/article/details/52840443

解决了吗

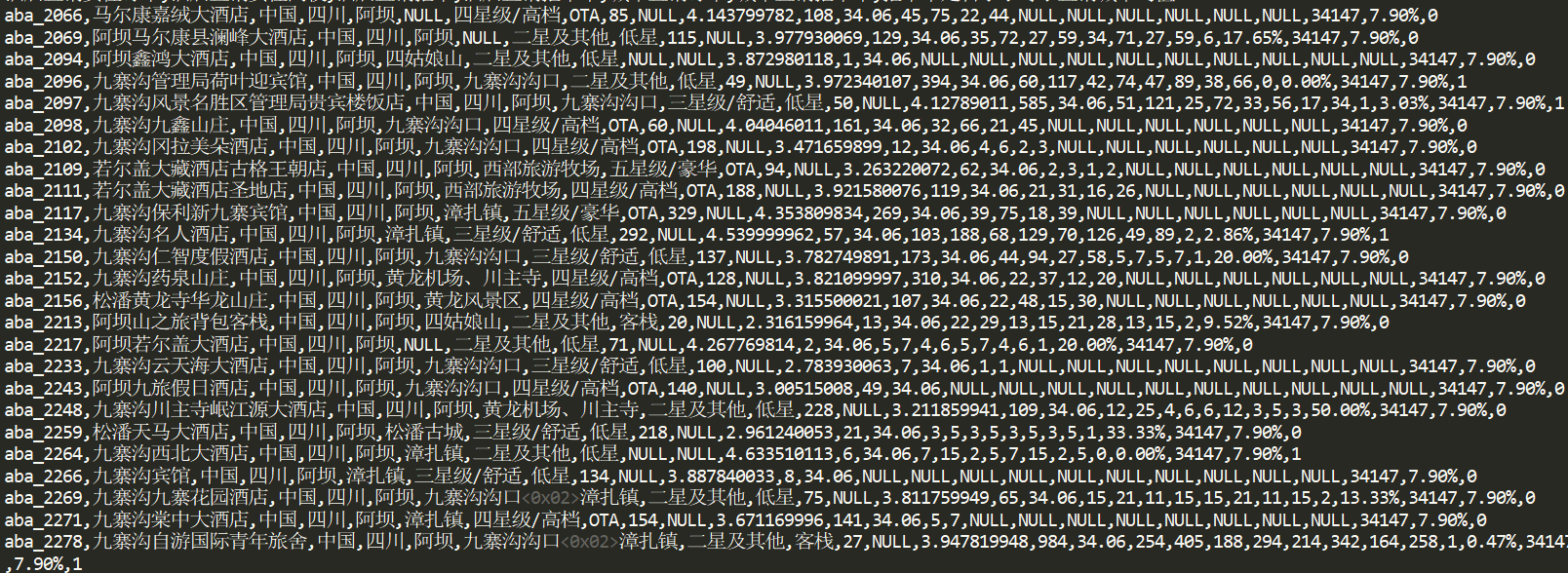

原数据如图。纯新手,最近才接触spark,实在不懂spark的机制,因为在mapreduce里map类里写的每行程序都是针对数据的每一行的,然而spark里textFile读取文件中的每一行后,无论用map还是flatMap遍历后,每行“,”分割的数据都会独立起来,后面filter的操作就没有意义 ,用Java,scala都行

https://blog.csdn.net/mtj66/article/details/52840443

解决了吗