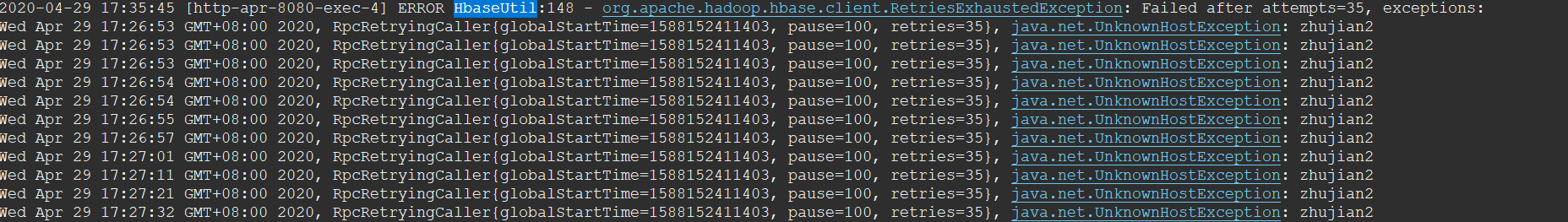

Hbase报这样的错误是为什么啊?怎么改啊?

Hbase报以下错误,要怎么解决啊,第一次接触这个东西

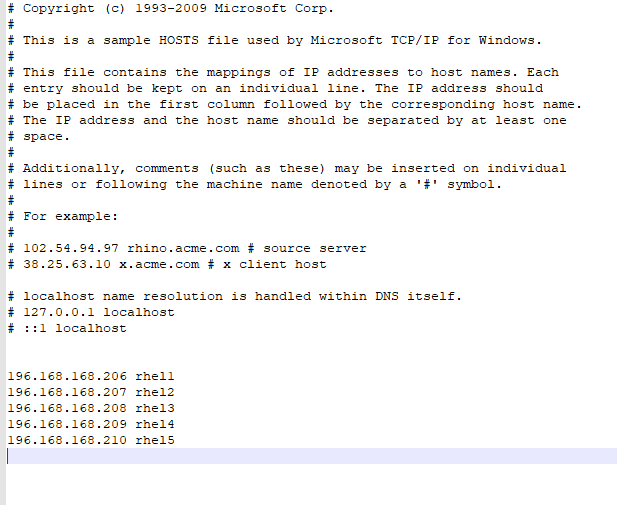

这个是我host的配置

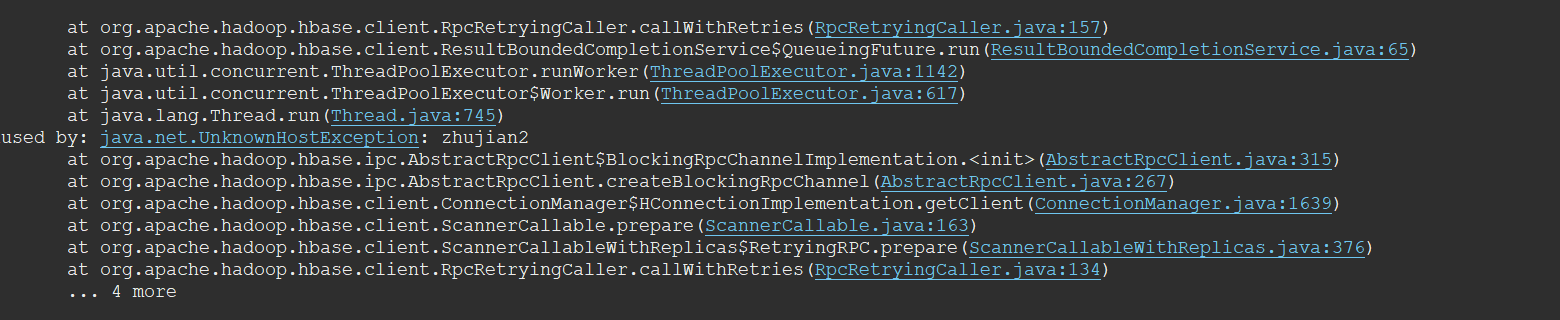

任务执行过程中,尝试了35次后还是失败的,然后抛出异常

出现问题的情况:由于数据倾斜,数据过大,计算复杂度过高,资源不足,节点故障,网络异常,差不多这些原因导致的,

你可以试试:

调整集群资源,比如说,增加节点,增加内存,增加cpu,这些

调整MapReduce任务的参数,增加:mapreduce.job.max-attempts、mapreduce.task.timeout

job.getConfiguration().set("mapreduce.job.max-attempts", "1");

job.getConfiguration().set("mapreduce.reduce.max-attempts", "1");优化MapReduce程序的代码,比如:减少数据的读写,减少计算的复杂度

分析数据的特点,比如:数据分布,数据倾斜等,然后采用适合的算法和数据结构进行处理