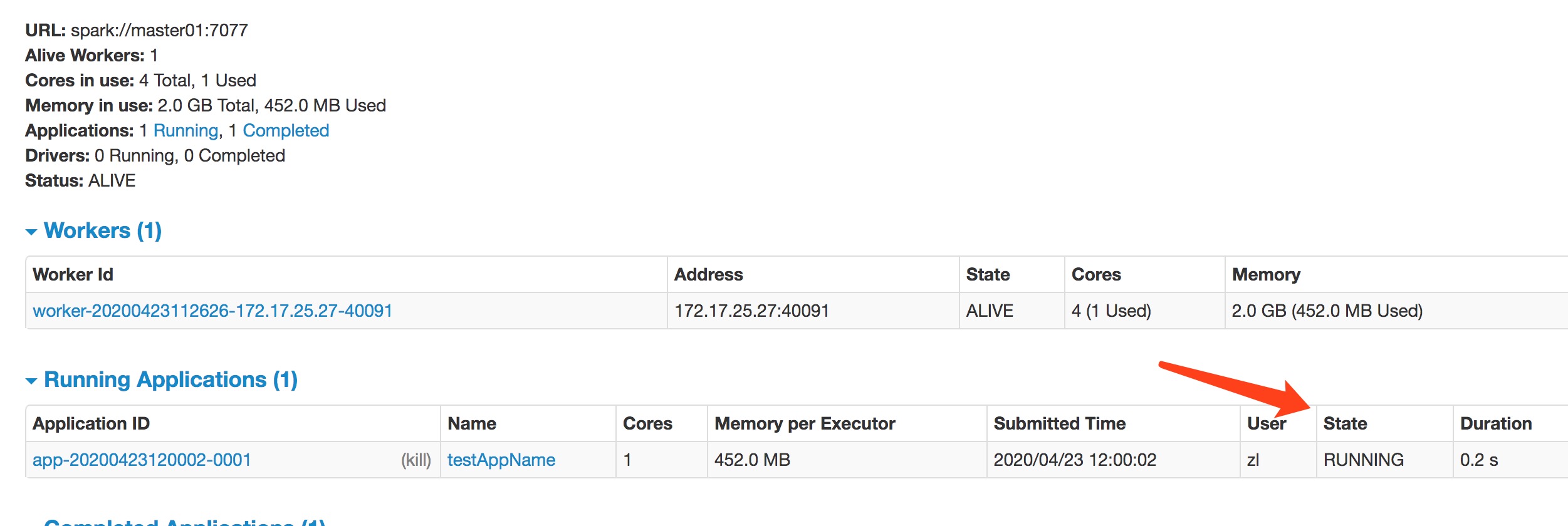

java提交spark任务一直出现 Initial job has not accepted any resources;

1、spark2.4.5版本

2、确保资源充足

3、网络上写资源不足,cpu不足;我这边都配置了。

运行时状态一直处于running状态

4-我指定了452MB运行;1cpu 。且只是简单的运行

JavaRDD parallelize = sc.parallelize(Arrays.asList(1, 2, 3, 4, 5));

Integer reduce = parallelize.reduce((a, b) -> a + b);

您好,这个问题解决了吗?我也遇到同样的问题,实在不知道如何解决