关于python网络爬虫网页失效的处理提问

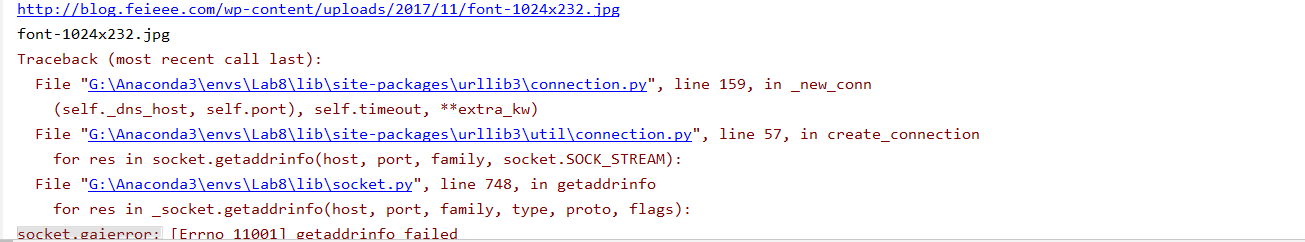

小弟在做网络爬虫抓取网站上所有的图片,但是有些图片的链接是失效的。我用的request连接这些网站,在把request得到的东西写入到本地电脑中。可是碰到无效网站时,request就会报错,后续就进行不下去了,怎么处理这个问题呢

image_file=open(im_name,'wb')

imgs=requests.get(im_iter) #im_iter是我用正则表达式截出来的图片链接

image_file.write(imgs.content)

image_file.close()

这是小弟保存图片的代码

try:

可能出错的语句

except :

pass

多找一下是不是空格多了