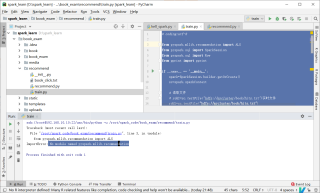

pyspark no module named pyspark.ml.functions

怎么解决 pyspark

no module named pyspark.ml.functions

换一个版本

不知道你这个问题是否已经解决, 如果还没有解决的话:- 你可以参考下这个问题的回答, 看看是否对你有帮助, 链接: https://ask.csdn.net/questions/688018

- 这篇博客你也可以参考下:pyspark系列--连接pyspark

- 除此之外, 这篇博客: Spark:相关错误总结中的 importerror no module named 'pyspark' 部分也许能够解决你的问题, 你可以仔细阅读以下内容或者直接跳转源博客中阅读:

可能出错原因:

1 设置的路径应该在import语句之前

2 pyspark_python路径出错,且如果在pycharm中修改后要重启pycharm才能生效,否则还是原来的路径(可能是因为之前的路径也保存在pycharm解释器中了?)

PYSPARK_PYTHON = /home/pipi/opt/anaconda3/bin/python

Note: 并不用设置py4j的路径。

皮皮blog

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^