需要自然语言处理方面的帮助

一篇中文报告,现在的类型、格式不固定,我需要提取其中子标题为“经过”或者包含该字眼的部分,然后这一段的长度不固定,我需要将”经过“这一部分完整的提取出来,但是我不知道后续的子标题,也不知道这一段话的长度,也没法使用句号进行分割。使用python

看不明白你写的,你把需求讲清楚一点儿。

描述不太清楚,我按照我理解的写的。这个代码会读取文件中的文本,然后使用正则表达式搜索包含“经过”之后的所有内容。如果找到了匹配项,那么就提取这段文字并将其打印出来。

import re

# 读取文章

with open('article.txt', 'r', encoding='utf-8') as f:

article_text = f.read()

# 提取“经过”之后的内容

match = re.search(r'经过(.*)', article_text)

if match:

extracted_text = match.group(1)

# 输出提取的内容

print(extracted_text)

来自GPT的回答:

你可以使用Python中的字符串处理方法来获取你需要的部分。具体来说,你可以使用字符串的find方法找到“经过”这个词在文章中的位置,然后使用切片操作从该位置开始提取文章的剩余部分。

以下是示例代码:

python

Copy code

article = """

这是一篇中文文章,经过了一番修整,变得非常优美。文章的主题是关于自然和人类之间的关系。在这篇文章中,我们将探讨人类如何与自然和谐共存。

"""

start = article.find("经过")

if start != -1:

excerpt = article[start:]

print(excerpt)

else:

print("文章中未找到'经过'这个词。")

在这个例子中,我们定义了一个字符串article来存储文章的内容。然后,我们使用find方法查找字符串中第一次出现“经过”这个词的位置,并将结果存储在变量start中。如果find方法找到了这个词,则start变量的值为该词在字符串中的索引,否则为-1。

接下来,我们使用切片操作将文章的剩余部分提取出来,并将结果存储在变量excerpt中。最后,我们使用print函数将结果输出到屏幕上。

如果文章中未找到“经过”这个词,则程序会输出一个相应的提示信息。

要使用Python和自然语言处理库来提取一篇中文文章中以“经过”开头的部分,你可以使用jieba库来进行分词,然后根据你的需求进行处理。这里是一个简单的示例:

首先,确保你已经安装了jieba库:

pip install jieba

接下来,你可以编写以下代码来处理你的中文文章:

import jieba

# 示例文章

article = '''

这里是你的中文文章。这篇文章包含了很多信息。

经过一番努力,我们终于完成了这个任务。

接下来,我们将继续努力。

'''

# 使用jieba进行分词

words = list(jieba.cut(article))

# 在分词结果中查找以“经过”开头的句子

target_sentence = ''

for i, word in enumerate(words):

if word == '经过':

target_sentence = ''.join(words[i:i+10]) # 获取以“经过”开头的10个词,可以根据需要更改

break

print(target_sentence)

在这个示例中,我们首先使用jieba库对文章进行了分词。然后,我们遍历分词结果,找到以“经过”开头的部分。你可以根据需要修改代码以获取所需的内容。

- 你可以看下这个问题的回答https://ask.csdn.net/questions/7768811

- 你也可以参考下这篇文章:**Python从键盘上输入一些数字组成两个集合,然后通过调用适用于所有集合的相关方法(交集,并集,差集和对称差集)

- 同时,你还可以查看手册:python- 用列表实现堆栈 中的内容

- 除此之外, 这篇博客: 【笔试】python刷题笔记(基础)!中的 输出字符串排序的不同方法,每个方法一个组合,集合成一个非常规对象,有重复的 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

import itertools class Solution: def Permutation(self, ss): # write code here if not ss: return [] return sorted(list(set(map(''.join, itertools.permutations(ss))))) #map(''.join,A) 转化为字符串组成的对象 #set() 返回无重复元素集,降重;可以看作不能重复的集合,也可看做set()对象。 #list() 转化为列表 #sorted() 排序d={} numbers=[1,1,2,2,2,3,3,3] for i in numbers: try: dict[i]+=1 except: dict[i]=1a={1:2,3:4,5:1} b=dict(sorted(a.items(),key=lambda b:b[1])) print(b)try: fun() do something1 expect: do something2while True: try: a=sys.stdin.readline().strip() if not a: break fun() except: break#sort()改变了a,且不能赋值给b。 a=[1,4,3,2] a.sort() print(a) #sorted()未改变a,改变后的对象赋值给b。 a=[1,4,3,2] b=sorted(a) print(a,b)s.find('a'):返回s中a的最小索引

s.rfind('a'):返回s中a的最大索引

list.index(a):返回list中a的最小索引

import collections d = collections.OrderedDict() #有序字典(输出顺序与添加顺序有关//无序字典无关) a = collections.Counter(b) #计数器,Counter类型,加dict变成计数字典在对问题求解时,总是作出在当前看来是最好的选择。(一件事情分为很多步,每步都做最好的选择)(局部最优>>全局最优,必须无后效性)

每次决策依赖于当前状态,又随即引起 ‘状态的转移’。一个‘决策序列’就是在变化的状态中产生出来的,所以,这种多阶段最优化决策解决问题的过程就称为动态规划。(经分解后得到的子问题往往不是互相独立的,即下一个子阶段的求解是建立在上一个子阶段的解的基础上,进行进一步的求解)

分治法的设计思想是:将一个难以直接解决的大问题,分割成一些规模较小的相同问题,以便各个击破,分而治之。

(回溯法=DFS+剪枝)

在包含问题的所有解的解空间树中,按照深度优先搜索的策略,从根结点出发深度探索解空间树。当探索到某一结点时,要先判断该结点是否包含问题的解,如果包含,就从该结点出发继续探索下去,如果该结点不包含问题的解,则逐层向其祖先结点回溯。(其实回溯法就是对隐式图的深度优先搜索算法)。

类似于回溯法,也是一种在问题的解空间树T上搜索问题解的算法。但在一般情况下,分支限界法与回溯法的求解目标不同。回溯法的求解目标是找出T中满足约束条件的所有解,而分支限界法的求解目标则是找出满足约束条件的一个解,或是在满足约束条件的解中找出使某一目标函数值达到极大或极小的解,即在某种意义下的最优解。

哈希表(Hash table,也叫散列表),是根据关键码值(Key value)而直接进行访问的数据结构。也就是说,它通过把关键码值映射到表中一个位置来访问记录,以加快查找的速度。这个映射函数叫做散列函数,存放记录的数组叫做散列表或哈希表。具体表现为: 存储位置 = f(key)

一棵空树或它的左右两个子树的高度差的绝对值不超过1,并且左右两个子树都是一棵平衡二叉树。

#遍历每个结点,借助一个获取树深度的递归函数,根据该结点的左右子树高度差判断是否平衡,然后递归地对左右子树进行判断。 class Solution: def IsBalanced_Solution(self, pRoot): # write code here if pRoot == None: return True if abs(self.TreeDepth(pRoot.left)-self.TreeDepth(pRoot.right)) > 1: return False return self.IsBalanced_Solution(pRoot.left) and self.IsBalanced_Solution(pRoot.right) def TreeDepth(self, pRoot): #计算树的深度 # write code here if pRoot == None: return 0 nLeft = self.TreeDepth(pRoot.left) #左子树的深度 nRight = self.TreeDepth(pRoot.right) return max(nLeft+1,nRight+1)

str.join(sequence)open()函数打开txt文件,返回 ‘file’ 类型;

file.readline( )方法 按照每一行划分,返回字符串组成的列表。

file = open('validation.txt','r') number_list=file.readlines() for i in range(len(number_list)): number_list[i]=number_list[i].strip() print(number_list)a=os.listdir('velodyne/') #参数为路径,后面要有‘/’ print(a)shutil.move(src_path+number+'.bin',target_path+number+'.bin') #文件名

最大堆:每个节点的值都大于等于它的孩子节点。

最小堆:每个节点的值都小于等于它的孩子节点。 对于下标为i的节点,它的子树的左节点的下标为2i,右节点为2i+1,父亲的节点下标为i/2(向下取整)。

看快慢指针是否相遇。

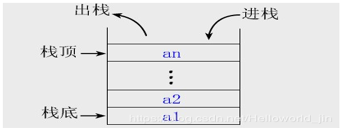

栈可以实现;递归需要保存正在计算的上下文, 等待当前计算完成后弹出,再继续计算, 只有栈先进后出的特性才能实现。

情况A: 路径经过左子树的最深节点,通过根节点,再到右子树的最深节点。

情况B: 路径不穿过根节点,而是左子树或右子树的最大距离路径,取其大者。 只需要计算这两个情况的路径距离,并取其大者,就是该二叉树的最大距离。

- 您还可以看一下 jeevan老师的Python量化交易,大操手量化投资系列课程之内功修炼篇课程中的 基础编程之股票行情构造小节, 巩固相关知识点

- 以下回答由chatgpt基于相关博客总结生成:

针对该问题,可以使用NLTK中的正则表达式和分块器来实现。

首先,需要将文本分成句子,使用NLTK的sent_tokenize函数:

import nltk text = "这是一篇中文文章。然后经过很多细节描述,最后得出了结论。" sentences = nltk.sent_tokenize(text)接下来,需要定义一个分块规则,来匹配开头为“然后经过”的句子和包含在其中的特定部分:

grammar = r""" NP: {<.*>+} #匹配名词短语 {<然后.*经过>} #匹配特定的句子结构 """然后,使用该规则来创建一个分块器:

cp = nltk.RegexpParser(grammar)最后,对于每个句子进行分块:

for sent in sentences: words = nltk.word_tokenize(sent) tagged = nltk.pos_tag(words) tree = cp.parse(tagged) for subtree in tree.subtrees(filter=lambda t: t.label() == 'NP'): print(subtree)完整代码如下:

import nltk text = "这是一篇中文文章。然后经过很多细节描述,最后得出了结论。" # 分成句子 sentences = nltk.sent_tokenize(text) # 定义分块规则 grammar = r""" NP: {<.*>+} #匹配名词短语 {<然后.*经过>} #匹配特定的句子结构 """ # 创建分块器 cp = nltk.RegexpParser(grammar) # 对于每个句子进行分块 for sent in sentences: words = nltk.word_tokenize(sent) tagged = nltk.pos_tag(words) tree = cp.parse(tagged) for subtree in tree.subtrees(filter=lambda t: t.label() == 'NP'): print(subtree)注意:该方法仅适用于中文中固定结构的情况,对于不确定结构的情况,需要考虑使用其他的中文自然语言处理工具和算法。