Linux上安装了Spark但无法运行,运行报错

在linux上无法运行Spark

报错信息如下

[root@node1 spark-3.2.4-bin-without-hadoop]# bin/run-example SparkPi

ERROR: class is not COMMAND nor fully qualified CLASSNAME.

Error: A JNI error has occurred, please check your installation and try again

请大家帮助解决一下这个问题,配置文件都配置好了的

- 这篇博客: spark安装踩坑中的 2.JNI error 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

报错:A JNI error has occurred, please check your installation and try again

这种情况是由于*/opt/module/spark-3.1.1-bin-without-hadoop/conf目录下的配置文件spark-env.sh.template*没有配置,首先使用如下命令:

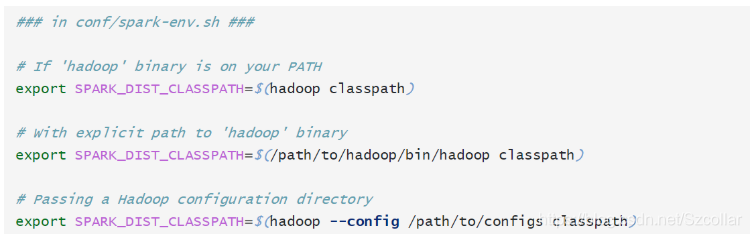

cp spark-env.sh.template spark-env.sh然后根据官方文档中的描述添加配置信息:

其中,/path/to/hadoop/bin/目录就是hadoop文件中bin文件所在目录

第三个信息中*/path/to/configs*目录表示的是hadoop配置信息(各个xml文件)所在目录,我的是

/opt/module/hadoop-3.1.3/etc/hadoop

网上搜了一下应该是Java和jdk版本不匹配

参考文章