深度学习训练网络时遇到问题

就是下面这个问题

搜到的所有答案都跟我的错误类型不一样,用了他们的方法都解决不了

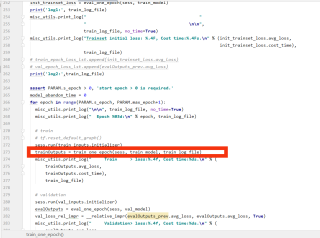

主程序运行到这一步就结束了

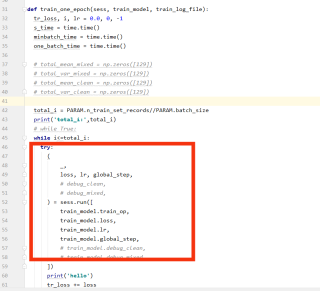

函数运行到这一步,能打印出上面的total i,不能打印出下面的hello,希望各位帮我看看,到底要怎么解决啊

以下内容部分参考ChatGPT模型:

这个问题可能是由于在训练过程中出现了NaN(不是数字)的值导致的。可以尝试以下几个方法来解决:

检查训练数据是否包含NaN值,如果有,将其删除或通过插值替换。

尝试使用更小的学习率,这可以防止梯度爆炸和梯度消失。

使用Batch Normalization来规范化输入数据,防止梯度爆炸和梯度消失。

尝试使用不同的优化器,如Adam或RMSprop,这些优化器可以更好地处理梯度问题。

尝试减小网络的深度或宽度,这可以减少梯度问题的发生。

尝试使用数值稳定的损失函数,如tf.keras.losses.logcosh。

使用tf.debugging.check_numerics函数检查张量是否包含NaN或无穷大的值。

例如,可以使用以下代码来检查张量是否包含NaN或无穷大的值:

import tensorflow as tf

tensor = tf.constant([1.0, 2.0, float('nan'), float('inf')])

check_op = tf.debugging.check_numerics(tensor, 'Invalid tensor')

with tf.Session() as sess:

sess.run(check_op)

希望这些方法可以帮助您解决问题。

如果我的建议对您有帮助、请点击采纳、祝您生活愉快

- 这有个类似的问题, 你可以参考下: https://ask.csdn.net/questions/7484914

以下答案由GPT-3.5大模型与博主波罗歌共同编写:

这种情况可能是程序中的某些错误使得程序提前结束,也可能是代码中出现了死循环等问题。下面是一些排查和解决这种问题的方法:

做好错误处理:在代码中添加try-except语句,以捕获可能出现的错误,并打印出详细的错误信息。

检查变量:在出现这种问题时,检查变量是否正确地被赋值和使用。可能是由于某个变量没有被正确初始化或者没有按照预期来赋值而导致问题出现。

打印调试信息:在代码中添加print语句,以打印出调试信息,看看在程序哪一步出了问题。

使用调试器:使用调试器来逐步执行代码,查看程序在哪一步出现了问题。

下面是一个简单的示例代码,可能有所帮助:

total = 0

for i in range(10):

try:

total += i

print("total i: ", total, i)

# 代码逻辑

except Exception as e:

print("Error: ", e)

raise

print("hello")

如果我的回答解决了您的问题,请采纳!