关于#matlab#的问题:采用优化算法优化LSTM后

采用优化算法优化LSTM后,结果比优化前的还要差,需要怎么修改代码,提升精度

当使用优化算法来优化LSTM模型时,可能会出现优化后的结果比优化前更差的情况。这可能是由于过度拟合、过度调整或其他原因导致的。

以下是一些可能提高LSTM模型精度的建议:

增加训练数据量:LSTM模型通常需要大量的训练数据才能获得良好的性能。如果您的训练数据集较小,可以尝试收集更多的数据或使用数据增强技术来扩充数据集。

调整模型结构:尝试使用更深或更宽的模型结构来提高模型的容量。也可以尝试使用其他类型的神经网络,如卷积神经网络(CNN)或变换器(Transformer)。

调整优化器参数:可以尝试调整优化器的学习率、动量、衰减系数等参数,以获得更好的训练效果。也可以尝试使用其他类型的优化器,如Adam、Adagrad或RMSprop。

集成多个模型:使用集成学习方法,将多个LSTM模型组合起来,可以显著提高模型的精度。可以使用投票、平均值或堆叠等集成方法。

进行正则化:使用正则化技术,如dropout、L1正则化或L2正则化,可以帮助减少过度拟合和提高模型的泛化能力。

调整超参数:LSTM模型有许多超参数,如LSTM层的数量、隐藏单元的数量、输入序列的长度等。调整这些超参数可以显著影响模型的性能,因此需要进行仔细的超参数搜索和调整。

需要注意的是,LSTM模型的性能提高往往是一个迭代的过程,需要不断地尝试不同的方法和技术,才能获得最佳的结果。

- 你可以参考下这个问题的回答, 看看是否对你有帮助, 链接: https://ask.csdn.net/questions/748529

- 我还给你找了一篇非常好的博客,你可以看看是否有帮助,链接:深度学习入门系列20:LSTM循环神经网络解决国际航空乘客预测问题

- 除此之外, 这篇博客: 【预测模型】基于贝叶斯优化的LSTM模型实现数据预测matlab源码中的 LSTM 网络 部分也许能够解决你的问题, 你可以仔细阅读以下内容或跳转源博客中阅读:

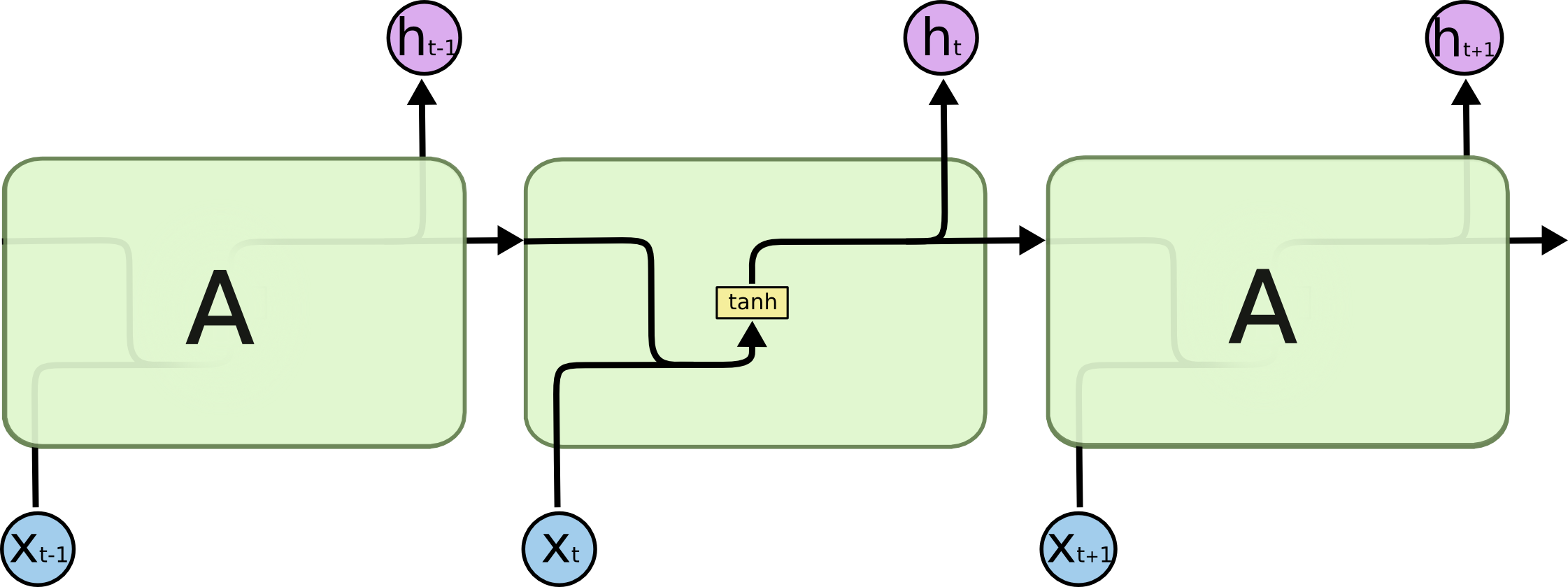

Long Short Term 网络—— 一般就叫做 LSTM ——是一种 RNN 特殊的类型,可以学习长期依赖信息。LSTM 由Hochreiter & Schmidhuber (1997)提出,并在近期被Alex Graves进行了改良和推广。在很多问题,LSTM 都取得相当巨大的成功,并得到了广泛的使用。 LSTM 通过刻意的设计来避免长期依赖问题。记住长期的信息在实践中是 LSTM 的默认行为,而非需要付出很大代价才能获得的能力! 所有 RNN 都具有一种重复神经网络模块的链式的形式。在标准的 RNN 中,这个重复的模块只有一个非常简单的结构,例如一个 tanh 层。

标准 RNN 中的重复模块包含单一的层

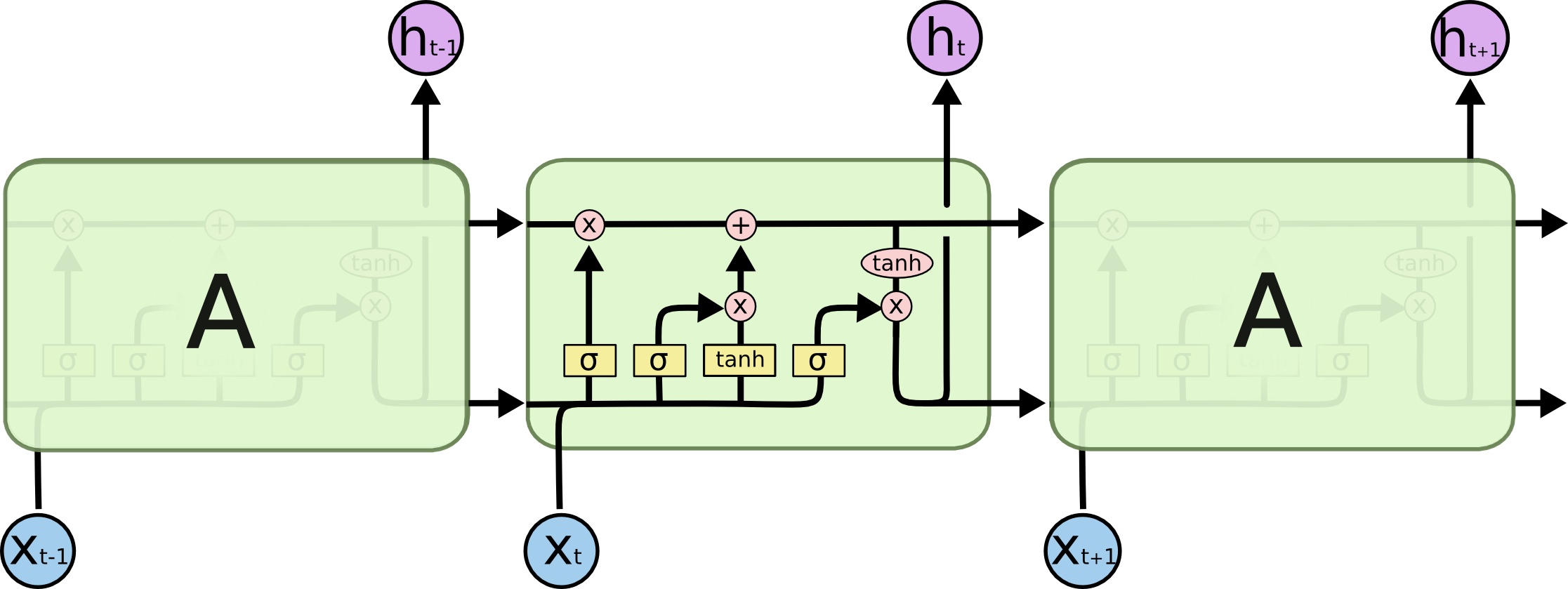

LSTM 同样是这样的结构,但是重复的模块拥有一个不同的结构。不同于 单一神经网络层,这里是有四个,以一种非常特殊的方式进行交互。

LSTM 中的重复模块包含四个交互的层

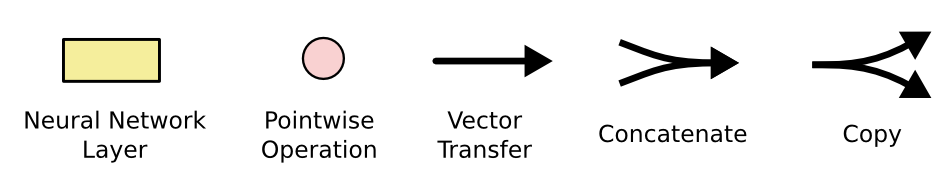

不必担心这里的细节。我们会一步一步地剖析 LSTM 解析图。现在,我们先来熟悉一下图中使用的各种元素的图标。

LSTM 中的图标

在上面的图例中,每一条黑线传输着一整个向量,从一个节点的输出到其他节点的输入。粉色的圈代表 pointwise 的操作,诸如向量的和,而黄色的矩阵就是学习到的神经网络层。合在一起的线表示向量的连接,分开的线表示内容被复制,然后分发到不同的位置。