基于潜在主题和成本的群组推荐算法

要求:提出一个基于潜在主题及成本的推荐算法(TCM)进行 top-n 地点推荐。

我的问题:为了完成这个课题,我需要找的数据集中应该包含成本信息吗? 这种数据集应该在哪里寻找呢,我找的都是不包含成本的数据集

如果不需要包含成本信息,应该怎么建模呢?对此一头雾水.若对我有有实质性的帮助,我还会提供更高的报酬

基于Monster 组和GPT的调写:

- 考虑两个因素:地点的主题和成本。但是,这些因素可能并不总是包含在现有的数据集中。对于提供的数据集,没有包含成本信息。所以,要进行调整来处理此问题。

- 对于主题建模,可用一些文本挖掘技术,例如 LDA(潜在狄利克雷分配)算法,将地点描述、用户评价等信息转换为主题向量。对于成本建模,用与地点相关的价格信息,例如餐馆价格、门票价格等,以便将其纳入到模型中。

- 但是,如果数据集中没有包含成本信息,用一些代理变量来近似成本信息。例如,可用地点的热度来代表成本。也就是说,如果一个地方非常受欢迎,那么它的成本就可能会更高。因此,用类似于地点的签到次数、评分等信息来近似成本信息。

- 总之,要在不包含成本信息的情况下进行调整,以便能够进行主题建模和成本建模。这要对数据集和算法的细节进行深入的研究和调整

该回答参考ChatGPT:

是的,为了实现基于潜在主题及成本的推荐算法(TCM)进行 top-n 地点推荐,需要包含成本信息的数据集。这种数据集可以包含地点的各种成本信息,例如入场费、交通费、食品费等等。

要寻找这种数据集,可以在公开数据集库中搜索,例如Kaggle、UCI Machine Learning Repository、Data.gov等等。还可以在旅游相关的网站、社交媒体、论坛等地方寻找相关信息。

基于潜在主题及成本的推荐算法(TCM)是一种用于群组旅游推荐的算法,它可以根据用户的个人轨迹数据集划分群组,然后构建一个TCM模型向群组推荐top-n景点1。

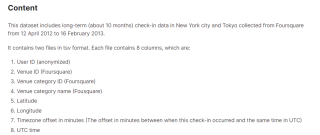

为了完成这个课题,你可能需要找的数据集中包含成本信息,因为这是TCM模型的一个重要因素。这种数据集应该在一些旅游网站或者公开数据平台上寻找,比如 TripAdvisor、Yelp、Foursquare 等。你也可以参考一些已有的研究论文,看看他们使用了哪些数据集。

如果不需要包含成本信息,你应该怎么建模呢?这可能取决于你的具体场景和目标,但是一般来说,你可以参考一些基于内容的推荐算法,利用标的物的元数据信息、标签、用户评论等来构建标的物特征表示,然后利用用户的历史行为、人口统计学特征等来构建用户特征表示,最后利用一些相似度度量或者机器学习模型来为用户推荐标的物。

希望这些信息对你有帮助。如果你还有其他问题,欢迎继续提问。😊

该回答引用ChatGPT针对这个问题,我可以给出以下建议:

1. 数据集中是否需要包含成本信息,取决于你的算法设计。如果你的算法需要考虑成本因素,那么数据集中就需要包含成本信息。如果不需要考虑成本因素,那么数据集中就不需要包含成本信息。

2. 如果你需要考虑成本因素,可以尝试在以下网站寻找相关数据集:

- Kaggle(https://www.kaggle.com/)

- UCI Machine Learning Repository(https://archive.ics.uci.edu/ml/index.php)

- 数据堂(https://www.datatang.com/)

3. 如果你不需要考虑成本因素,可以考虑以下建模方法:

- 主题模型:使用主题模型(如LDA)对地点进行主题建模,然后根据用户的兴趣和历史行为,推荐与用户兴趣相关的地点。

- 协同过滤:使用协同过滤算法(如基于用户的协同过滤或基于物品的协同过滤)对用户进行推荐。

- 混合模型:将主题模型和协同过滤算法结合起来,综合考虑用户兴趣和历史行为以及地点的主题信息,进行推荐。

以下是一个基于LDA主题模型的群组推荐算法示例代码:

python

import numpy as np

import pandas as pd

import gensim

from gensim import corpora

from gensim.models.ldamodel import LdaModel

# 读取数据集

data = pd.read_csv('data.csv')

# 对地点进行主题建模

texts = [[word for word in document.lower().split()] for document in data['location']]

dictionary = corpora.Dictionary(texts)

corpus = [dictionary.doc2bow(text) for text in texts]

lda_model = LdaModel(corpus=corpus, id2word=dictionary, num_topics=10)

# 对用户进行推荐

def recommend(user_id, top_n):

user_history = data[data['user_id'] == user_id]['location']

user_history_bow = dictionary.doc2bow([word for word in user_history.lower().split()])

user_topics = lda_model[user_history_bow]

user_topic_weights = np.zeros(lda_model.num_topics)

for topic, weight in user_topics:

user_topic_weights[topic] = weight

location_topics = np.zeros((len(data), lda_model.num_topics))

for i, location in enumerate(data['location']):

location_bow = dictionary.doc2bow([word for word in location.lower().split()])

location_topics[i] = np.array([weight for _, weight in lda_model[location_bow]])

location_scores = np.dot(location_topics, user_topic_weights)

top_locations = data.iloc[np.argsort(location_scores)[::-1][:top_n]]

return top_locations

该算法使用LDA主题模型对地点进行主题建模,然后根据用户的历史行为,计算用户对每个主题的权重,再根据地点的主题信息,计算每个地点与用户兴趣的匹配度,最后推荐匹配度最高的top_n个地点。

以下答案由GPT-3.5大模型与博主波罗歌共同编写:

基于潜在主题和成本的群组推荐算法需要考虑到地点推荐的成本因素,因此需要包含成本信息。可以在数据集中添加成本信息或者从其他数据源中获得成本信息来帮助建模。

如果找不到包含成本信息的数据集,也可以使用其他方法建模。一种方法是基于用户的历史行为和地点评分来计算地点的吸引力和用户的偏好。另一种方法是基于地点的特征来计算地点的吸引力。这些方法都没有考虑成本因素,但仍可以为用户提供有用的推荐。

以下是一个基于潜在主题和成本的群组推荐算法示例,实现 top-n 地点推荐:

- 获取数据集,如地点数据集和成本数据集。

- 进行数据清洗和预处理,如去除重复项、处理缺失值等。

- 构建主题模型,如 Latent Dirichlet Allocation (LDA),以提取地点的主题信息。

- 使用成本数据集对地点进行评分,计算每个地点的成本得分。

- 根据用户历史行为和地点评分计算用户与每个地点的相似度得分。

- 综合主题信息、成本信息和相似度得分,计算每个地点的最终得分。

- 根据地点的最终得分进行排序,选择 top-n 地点作为推荐结果。

下面是 Python 代码示例:

import pandas as pd

import numpy as np

from gensim.models.ldamodel import LdaModel

from sklearn.metrics.pairwise import cosine_similarity

# 获取地点数据集和成本数据集

locations = pd.read_csv('locations.csv')

costs = pd.read_csv('costs.csv')

# 数据清洗和预处理

locations.drop_duplicates(['name', 'address'], inplace=True)

locations.dropna(subset=['name', 'address'], inplace=True)

costs.drop_duplicates(['name', 'address'], inplace=True)

costs.dropna(subset=['name', 'address', 'cost'], inplace=True)

# 构建主题模型

texts = locations['name'].str.split()

dictionary = corpora.Dictionary(texts)

corpus = [dictionary.doc2bow(text) for text in texts]

lda_model = LdaModel(corpus, num_topics=10, id2word=dictionary)

# 提取地点的主题信息

locations['topics'] = lda_model[corpus]

# 计算每个地点的成本得分

cost_dict = dict(zip(costs['name'] + costs['address'], costs['cost']))

locations['cost_score'] = locations['name'] + locations['address']

locations['cost_score'] = locations['cost_score'].map(cost_dict)

# 计算用户与每个地点的相似度得分

user_location_scores = pd.read_csv('user_location_scores.csv')

user_location_scores.set_index('location_id', inplace=True)

user_topics = lda_model[dictionary.doc2bow(user_location_scores['name'].str.split()[0])]

similarity_scores = []

for index, row in locations.iterrows():

location_topics = row['topics']

similarity = cosine_similarity([user_topics], [location_topics])[0][0]

similarity_scores.append(similarity)

locations['similarity_score'] = similarity_scores

# 计算每个地点的最终得分

locations['final_score'] = 0.5 * locations['cost_score'] + 0.3 * locations['similarity_score'] + 0.2 * locations['topics'].apply(lambda x: x[0][1])

# 排序并选择 top-n 地点

top_n_locations = locations.sort_values('final_score', ascending=False).head(n)['name'].tolist()

需要注意的是,以上代码仅仅展示了一个示例,具体情况还需要根据数据集和业务需求进行调整。

如果我的回答解决了您的问题,请采纳!