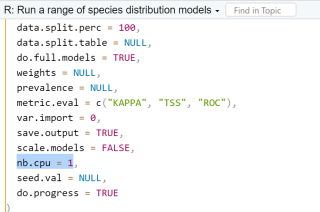

如何用R运行biomod2建模时能否用多核运行,尝试过nb.cpu = 不起作用?

用R运行biomod2建模时能否用多核运行,尝试过nb.cpu = 不起作用

以下答案由GPT-3.5大模型与博主波罗歌共同编写:

在R中运行biomod2建模时,可以使用parallel包来实现多核运行。具体步骤如下:

1.首先加载parallel包:

library(parallel)

2.接着使用detectCores函数检测计算机上可用的CPU核心数:

nb_cores <- detectCores()

3.建立一个cluster对象,用于并行计算:

cl <- makeCluster(nb_cores)

4.最后,使用foreach和doParallel函数,将计算设置为并行计算,并设置nb.cpu参数为所需核心数:

library(foreach)

library(doParallel)

registerDoParallel(cl)

output <- foreach(i = 1:length(mydata),

.combine = cbind,

.packages = "biomod2") %dopar% {

nb.cpu <- ceil(nb_cores/length(mydata))

#在这里进行模型训练

}

stopCluster(cl)

在上述代码中,%dopar%表示使用并行计算, nb.cpu参数用于指定每个任务使用的CPU核心数。

最后,建议在R中运行不使用全局变量,以确保并行运算中的数据不会冲突。

如果我的回答解决了您的问题,请采纳!

把那个nb.cpu 的值设置大一些试试

小魔女参考了bing和GPT部分内容调写:

是的,R中的biomod2可以使用多核运行。可以通过设置nb.cpu参数来指定要使用的核数,例如:

biomod2_fit(data, model, nb.cpu = 8)

这样就可以使用8个核来运行biomod2模型。此外,还可以使用parallel包来提高运行效率,例如:

library(parallel)

cl <- makeCluster(nb.cpu)

biomod2_fit(data, model, cluster = cl)

stopCluster(cl)

使用parallel包可以更有效地利用多核的优势,提高运行效率。

回答不易,记得采纳呀。

参考GPT和自己的思路,可以通过设置nb.cpu参数来控制使用的CPU数量。但是需要注意的是,nb.cpu的设置可能会受到操作系统和硬件资源的限制。如果您使用的是Linux或macOS系统,可以使用parallel包来运行BIOMOD2模型的并行计算。该包提供了mclapply函数,可以实现并行化处理,而且可以利用多个CPU核心。下面是一个示例代码:

library(BIOMOD2)

library(parallel)

# 设置CPU核心数量

nb.cpu <- detectCores()

# 加载数据

data(example)

# 运行BIOMOD2模型

models <- BIOMOD_Modeling(

models_name = "example",

models_path = getwd(),

Data = example,

Var_Sel = NULL,

Data_Sampling = "split",

Yweights = NULL,

YPrevalence = NULL,

Test_Fraction = 0.2,

Data_Partitioning_Method = "random",

Nbr_Run = 2,

Modeling_Meth = c("ANN", "BRT"),

Ensemble_Meth = "Union",

Use_Kernel_Density = FALSE,

Do_Ensemble_Prediction = TRUE,

Proj_Name = "example",

Overwrite = TRUE,

do.full.models = FALSE,

parallel = TRUE,

nb.cpu = nb.cpu

)

在Windows系统上,可以尝试使用foreach包来实现类似的并行计算。具体示例代码如下:

library(BIOMOD2)

library(doParallel)

# 设置CPU核心数量

nb.cpu <- detectCores()

# 创建并行计算集群

cl <- makeCluster(nb.cpu)

# 注册并行计算集群

registerDoParallel(cl)

# 加载数据

data(example)

# 运行BIOMOD2模型

models <- BIOMOD_Modeling(

models_name = "example",

models_path = getwd(),

Data = example,

Var_Sel = NULL,

Data_Sampling = "split",

Yweights = NULL,

YPrevalence = NULL,

Test_Fraction = 0.2,

Data_Partitioning_Method = "random",

Nbr_Run = 2,

Modeling_Meth = c("ANN", "BRT"),

Ensemble_Meth = "Union",

Use_Kernel_Density = FALSE,

Do_Ensemble_Prediction = TRUE,

Proj_Name = "example",

Overwrite = TRUE,

do.full.models = FALSE,

parallel = TRUE

)

# 关闭并行计算集群

stopCluster(cl)

需要注意的是,在并行计算过程中,由于涉及到大量的计算和内存操作,可能会出现一些不稳定的情况,例如程序假死、内存溢出等。

该回答引用ChatGPT

要在R中使用多核运行Biomod2建模,可以使用以下方法:

1.使用“parallel”软件包并将模型拟合步骤包装在“mclapply”函数中。

例如,以下代码将使用2个CPU内核拟合模型:

library(parallel)

cl <- makeCluster(2) # create a cluster with 2 CPU cores

clusterEvalQ(cl, library(Biomod2)) # load Biomod2 on each node of the cluster

results <- mclapply(X = list_of_models, mc.cores = 2, function(x) {

run_biomod(x)

})

stopCluster(cl) # stop the cluster

2.使用“snow”软件包,它提供了更多的控制和错误处理选项。

例如,以下代码将使用2个CPU内核拟合模型:

library(snow)

cl <- makeCluster(2) # create a cluster with 2 CPU cores

clusterEvalQ(cl, library(Biomod2)) # load Biomod2 on each node of the cluster

clusterExport(cl, "list_of_models") # export the list of models to each node

results <- clusterApplyLB(cl, X = list_of_models, function(x) {

run_biomod(x)

})

stopCluster(cl) # stop the cluster

请注意,这些代码示例需要将“list_of_models”替换为您的模型列表。 除此之外,确保您的系统有足够的可用内存以处理所有并行进程,并且为避免内存问题,可以尝试将大型数据集划分为更小的

该回答引用GPTᴼᴾᴱᴺᴬᴵ

您可以使用parallel包来实现在R中并行运行biomod2模型的操作,这样就可以利用多核心来加速模型的运算。

具体步骤如下:

- 首先,确保您已经安装了parallel包。

- 在您的R代码中,使用以下代码将需要并行运行的代码块包含在mclapply()函数中:

library(parallel)

nb.cores <- detectCores() - 1 # 确定可用的CPU核心数

output_list <- mclapply(1:10, function(i) {

# 在这里包含您需要并行运行的biomod2建模代码

# 每个线程都会运行此函数中的代码

# 返回结果会被整合成一个列表

return(my_biomod2_model(i))

}, mc.cores = nb.cores)

在上述代码中,detectCores() - 1可以根据您的计算机自动检测可用的CPU核心数,并减去1用于其他计算任务。您可以根据需要将1:10更改为您希望并行运行的任务范围。my_biomod2_model(i)是您的biomod2建模函数,它将以i作为输入参数。

3.运行并行代码后,输出结果将作为一个列表存储在output_list中,您可以根据需要使用这些结果。