tensorflow.keras训练模型预测问题

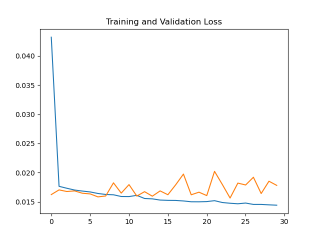

请问在使用tensorflow.keras训练模型预测时val_loss变化非常奇怪

loss是正常下降,但val_loss一开始就很低,而且一直震荡

如下图

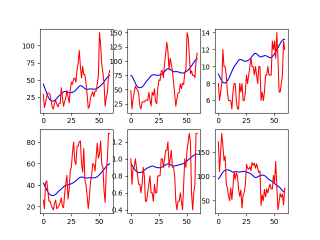

最后预测结果也很差,如下图

我训练的模型如下

Xtrain.shape, Xtest.shape, Ytrain.shape, Ytest.shape为(2036, 60, 6) (400, 60, 6) (2036, 60, 6) (400, 60, 6)

model = keras.models.Sequential()

model.add(keras.layers.LSTM(40, input_shape=(Xtrain.shape[1:]), return_sequences=True, ))

model.add(keras.layers.Dropout(0.1))

model.add(keras.layers.LSTM(30, return_sequences=True)) # model.add(keras.layers.Dropout(0.5))

model.add(keras.layers.Dropout(0.1))

model.add(keras.layers.LSTM(40, return_sequences=True))

model.add(keras.layers.Dropout(0.1))

model.add(keras.layers.LSTM(40, return_sequences=True))

model.add(keras.layers.BatchNormalization()) # 批标准化:对一小批数据(batch)做标准化处理(使数据符合均值为0,标准差为1分布)

model.add(keras.layers.TimeDistributed(keras.layers.Dense(Ytrain.shape[2])))

model.compile(optimizer=keras.optimizers.Adam(lr=0.0001, amsgrad=True), loss='mse') # mae: mean_absolute_error

model.summary()

history = model.fit(

Xtrain, Ytrain,

validation_data=(Xtest, Ytest),

batch_size=32,

epochs=30,

verbose=1)

预测部分代码如下

predict = model.predict(Xtest)

predict = scalar.inverse_transform(predict[0])

Ytesting = scalar.inverse_transform(Ytest[0])

for i in range(6):

plt.subplot(2, 3, i + 1)

plt.plot(predict[:, i], color='blue')

plt.plot(Ytesting[:, i], color='red')

plt.show()

请问是模型结构问题还是模型参数问题啊,亦或者训练模型的数据集有问题啊

这种情况可能是由于模型在训练过程中出现了过拟合的现象。过拟合通常是指模型在训练集上表现很好,但在测试集上表现不佳的情况。在训练过程中,模型过度适应了训练集的噪声和特定的样本,从而导致了 val_loss 震荡。

要解决这个问题,可以尝试以下几种方法:

增加训练数据量:通过增加训练数据量,可以减少模型的过拟合现象。

添加正则化项:在模型中添加正则化项,如 L1 或 L2 正则化,可以限制模型的复杂度,减少过拟合现象。

使用早期停止技术:在训练过程中,可以通过监控验证集上的 loss 值来确定模型是否开始出现过拟合。一旦发现过拟合现象,就可以通过早期停止来防止模型继续训练。

减小模型复杂度:通过减小模型的复杂度,如减少层数、神经元数等,可以降低过拟合现象的发生概率。

希望以上方法可以帮助您解决问题。

- 文章:安装Tensorflow和keras遇到的一些问题及解决 中也许有你想要的答案,请看下吧

- 同时,你还可以查看手册:tensorflow 使用 TensorFlow Cloud 训练 Keras 模型 中的内容