关于spark在Windows环境下的配置启动问题

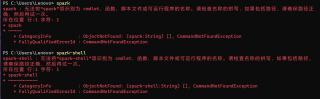

如图,环境变量已经添加,同对应的hadoop和scala也已经成功配置并启动,只有spark启动失败

如果您在 Windows 平台上安装了 Spark,并且无法找到 spark 和 spark-shell 命令,可以尝试以下几个方法:

检查环境变量:请确保将 Spark 的安装目录添加到系统的 PATH 环境变量中。可以通过在命令提示符下输入 echo %PATH% 来查看当前的 PATH 环境变量内容。

检查 Spark 安装目录:请确认 Spark 已经正确地安装在 Windows 系统上,并且 Spark 的 bin 目录下确实存在 spark.cmd 和 spark-shell.cmd 等可执行文件。如果您在安装时选择了不同的安装目录,可以根据实际情况进行调整。

检查 Java 安装:Spark 需要 Java 环境才能正常运行,如果 Java 环境未安装或者安装不正确,可能会导致 Spark 命令无法执行。可以通过在命令提示符下输入 java -version 来检查 Java 是否正确安装。

检查操作系统位数:请注意 Spark 的安装包要与操作系统位数匹配。如果您的操作系统是 64 位的,那么请确保您下载了 Spark 的 64 位版本,否则可能会出现无法执行的问题。

如果上述方法仍然无法解决问题,可以尝试重新安装 Spark 并检查所有配置和环境变量是否设置正确。

以下答案引用自GPT-3大模型,请合理使用:

在操作之前,先确定你已经正确安装了java、Hadoop和Spark。首先,可以在命令行打开“%SPARK_HOME%\conf”的路径,修改spark-env.cmd文件,将以下内容添加上

set JAVA_HOME=<你的Java安装路径>

set HADOOP_HOME=<你的Hadoop安装路径 >

set SPARK_MASTER_IP=<你的主机IP地址>

如果需要连接Hive,请添加以下配置

set HIVE_HOME=<你的Hive安装路径>

接着,运行$SPARK_HOME/sbin/start-all.cmd即可启动spark

如果还是不能启动,可以使用如下方式:

1. 首先运行$SPARK_HOME/sbin/start-master.cmd启动Master

2. 然后在另一个CMD窗口里运行$SPARK_HOME/sbin/start-slave.cmd spark://<你的主机IP地址>:7077即可启动Slave

3. 最后,在spark的webUI中确认已经设置成功,spark就启动成功了

如果我的回答解决了您的问题,请采纳我的回答

不知道你这个问题是否已经解决, 如果还没有解决的话:- 你看下这篇博客吧, 应该有用👉 :如何用Spark解决特征处理问题

如果你已经解决了该问题, 非常希望你能够分享一下解决方案, 写成博客, 将相关链接放在评论区, 以帮助更多的人 ^-^