Hive on Spark配置问题

最近重新编译好了Hive3.1.2,安装了纯净版的spark3.0.3

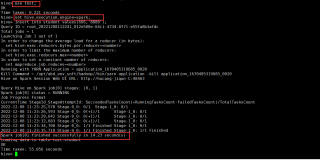

在hive命令窗口中测试语句如下

use test;set hive.execution.engine=spark;insert into student values(666,'7777');

并且没有什么问题

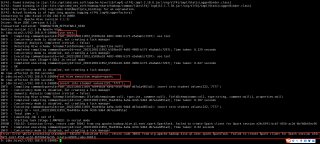

但是在beeline命令窗口中同样的操作却会报错无法启动spark客户端

想知道问题在哪里,求指点

再贴一下相关配置文件

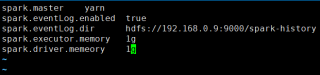

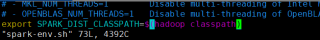

hive/conf/spark-defaults.conf

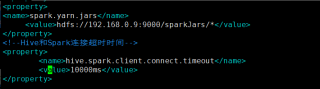

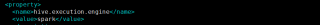

hive/conf/hive-site.xml 添加了如下内容,纯净版spark的jar包已经上传到了指定hdfs目录,没有设置默认引擎是spark,因为我想先手动设置,这个文件也copy到了spark/conf目录下

spark/conf/spark-env.sh,已配置环境变量

hive-seit.xml文件里面必须要添加设置 执行引擎为spark

使用 beeline -u jdbc:hive2://10.8.4.46:10000 -n root或者hive命令直接登录,登陆进去之后,执行:

set hive.execution.engine=spark;

set spark.master=yarn-cluster;

set mapreduce.job.queuename=ada.spark;

如有帮助,望采纳

可以提供一下HS2的详细日志看看,这里看不出什么问题