estimator的val loss远远大于train loss,可能是什么原因?

请教大佬们,tensorflow的estimator:val loss远远大于train loss,可能是什么原因造成的呢?截图如下:

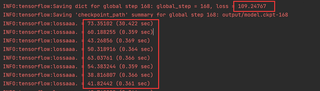

比如第168步的时候,loss已经降为40了。在接下来执行的eval过程中,loss为109,远远大于了40,如下

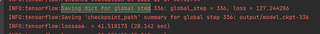

并且,在以后的每次eval中,loss稳步上升(但准确率也在上升),比如第二次eval的loss是129,如下

请问大佬们,这可能是什么原因呢?不知道是不是我的代码写错了。。还是参数没调对。

拜托拜托,求大佬发发慈悲帮帮忙

目前在跑的是bert模型,batch_size是16。

在使用 TensorFlow 中的 Estimator 时,如果 val loss 远远大于 train loss,可能是以下几个原因造成的:

数据划分不合理:在训练模型时,需要将数据划分为训练集和验证集,如果训练集和验证集的数据分布不同,模型在训练集上的表现可能会比在验证集上更好,导致 val loss 大于 train loss。

- 训练时间过短:如果模型的训练时间过短,模型可能没有达到收敛状态,导致 val loss 大于 train loss。

- 模型过拟合:如果模型过拟合训练集,即模型在训练集上的表现比在验证集和测试集上的表现更好,导致 val loss 大于 train loss。

- 正则化不足:如果模型没有进行足够的正则化,模型可能会过拟合训练集,导致 val loss 大于 train loss。

- 如果出现 val loss 远远大于 train loss 的情况,需要从上述几个方面入手,逐一排查问题并采取相应的措施。

补充一下,val loss一直升高,最终趋于平稳,同时val的准确率也一直在上升最终平稳,请问这个正常吗?