pyspark 显示No module named 'pyarrow'

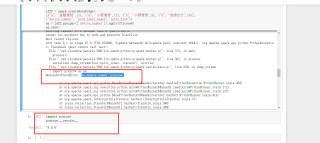

我现在需要利用pyspark进行如pandas.groupby().apply()的操作聚合数据,但是一直报错 No module named 'pyarrow',但是我实际上安装了pyarrow这个包

我查阅了许多网上的方法,但是都没有办法解决,无论是pip重新下载,还是官网的conda -c……

你好像是spark,

瞅瞅 https://blog.csdn.net/wl2858623940/article/details/81078830

你的pyspark路径为什么不是在site-packages里面?

如果是提交到了spark集群运行,

这种情况可能原因是本地节点安装了pyarrow,但是spark集群的其他节点没有安装pyarrow,当任务在未安装pyarrow的节点执行就会报找不到包