spark,这个该怎做,电脑不在身边,自己废

spark该怎么做😭😭,很重要,根本不知道怎么做,而且自己一迷迷糊糊,求各位看看

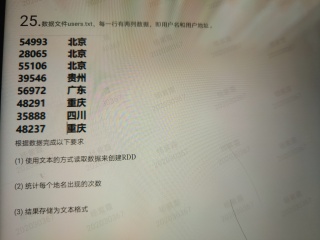

1.textFile()本地读取数据创建rdd,saveAstextFile()保存。处理直接用groupby算子。

⚠️Spark采用惰性机制,不会立即显示结果,

spark环境会建立吗

val conf: SparkConf = new SparkConf().setAppName("etlDemo").setMaster("local")

val sc: SparkContext = SparkContext.getOrCreate(conf)

val spark: SparkSession = SparkSession.builder().config(conf).getOrCreate()

import spark.implicits._

val testRDD: RDD[(String, Int)] = sc.textFile("in/in/test.log") //这是添加的文件的路径 第一问的答案

.map(x => x.split("\t")(1))

.map(x => (x, 1))

.reduceByKey(_ + _) //第二问的答案

testRDD.saveAsTextFile("你自己创建的路径") //第三问的答案

有不懂的可以私聊我,我看到回复你

val rdd = sc.textFile("hdfs://localhost:9000/myspark/wordcount/test.txt");