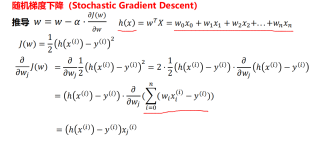

机器学习梯度下降的公式理解,求正解。

学习ML的梯度下降部分时,对随机梯度下降的梯度推导不太清楚,见下图,为什么sigma符号能把后面的yi也包进去?h(x)不是只等于w和x的相乘再相加么,要是将yi也加进去,那不就是i自增一下,式子就得减一个yi了?实在是没看明白,请求指正。

对,这里的求和号不应该把 y^(i) 也包含进去,不过由于外面是对 w_j 进行微分,与 y^(i) 无关,所以实际上最终结果不受到影响

学习ML的梯度下降部分时,对随机梯度下降的梯度推导不太清楚,见下图,为什么sigma符号能把后面的yi也包进去?h(x)不是只等于w和x的相乘再相加么,要是将yi也加进去,那不就是i自增一下,式子就得减一个yi了?实在是没看明白,请求指正。

对,这里的求和号不应该把 y^(i) 也包含进去,不过由于外面是对 w_j 进行微分,与 y^(i) 无关,所以实际上最终结果不受到影响