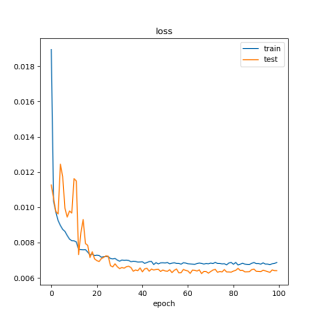

神经网络训练集的loss比测试集的大,这正常么?

训练集的loss一定比测试集的loss小,模型才对么?我的模型只设立了训练集和测试集(8:2),但网络训练出来,一直都是训练集的loss大于测试集的,我看其他人的论文里,基本都是训练集的loss小于测试集的loss,最后趋于稳定,判定模型收敛。

谁跟你说训练集一定小于测试集?这两个大小没有一定关系,真要细分的话训练集和验证集都不能算同一个数据集,没有绝对的大小之分。即使是两者分布一致,但是具体样本的偏差也会会导致结果的不一样(特别是训练集如果做了数据增强,而验证集没有),所以我们能简单粗暴的直接比较两者大小,而是看趋势是否同步下降,

想你这个训练集和验证集loss都在下降,这就是很正常的训练过程,

但是训练集loss下降了,而验证集loss反而上升了,这就是熟知的过拟合。

准确率一样的道理

训练集和验证集大小没有一定关系

一般来说,训练集损失率会低于测试集,因为训练集损失率是在网络中进行学习出来,测试集就是在模型训练好之后输入到模型中进行测试,不一定会符合模型,所以会高,你这个原因可能是数据集不够,或者网络模型参数不够好

不是很正常,一般训练集的loss会低点;

不过低的不多也有可能,可能训练集噪声比较多,

你的问题,估计是整体样本不多,以及可能有脏数据的原因。