spark on yarn 问题

请求帮帮忙!

spark on yarn 无法启动

最近在学习spark on yarn 内容,用 ./pyspark --master yarn 无法启动,总是报错:

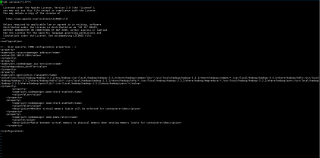

ERROR spark.SparkContext: Error initializing SparkContext.

hadoop 集群已经全部启动,我的hadoop是3.3.2 spark 是3.2.1

报错结果如下图:

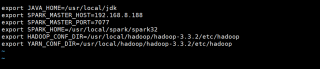

spark env 配置文件如下:

yarn yarn-site.xml配置文件如下:

仔细看日志信息,提示0个datanode了,也就是你的hdfs有问题,datanode都没起来,先去确定hdfs集群情况吧

将spark-defaults.conf和spark-env.sh 里面日志目录文件路径从单一NN改为命名空间的路径就好

我的命名空间是

<property>

<name>fs.defaultFS</name>

<value>hdfs://ruozeclusterg6</value>

</property>

修改spark-defaults.conf

spark.eventLog.enabled true

spark.eventLog.dir hdfs://ruozeclusterg6:8020/g6_direcory

修改spark-env.sh

SPARK_HISTORY_OPTS="-Dspark.history.fs.logDirectory=hdfs://ruozeclusterg6:8020/g6_direcory"

用户权限不够