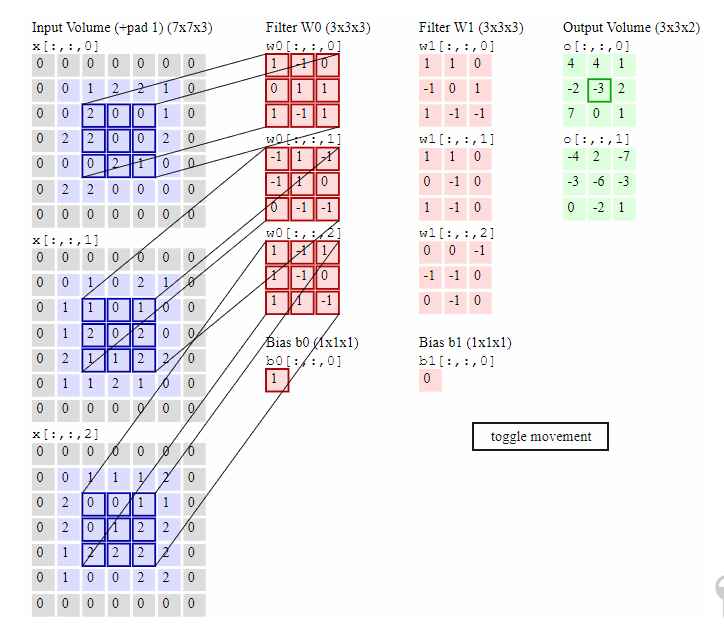

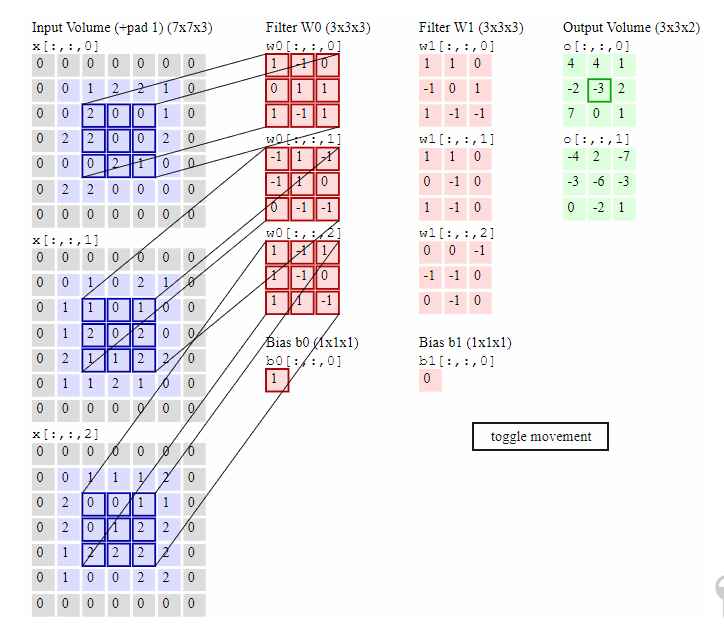

卷积神经网络中偏置的计算

例子中的偏置b0=1,b1=0;分别是怎么计算的啊,跪求大神指导

bias也好,height也好,都不是“计算”出来的,而是凑出来的。这个凑的过程叫做反向传播算法,比如说用梯度下降算法。

你好,请问为什么在你发的这幅图中,卷积后所得结果不论加不加偏置项都不为output的结果?

例子中的偏置b0=1,b1=0;分别是怎么计算的啊,跪求大神指导

bias也好,height也好,都不是“计算”出来的,而是凑出来的。这个凑的过程叫做反向传播算法,比如说用梯度下降算法。

你好,请问为什么在你发的这幅图中,卷积后所得结果不论加不加偏置项都不为output的结果?