SINet语义分割,所有像素预测结果是同一个值

问题遇到的现象和发生背景

使用SINet进行二分类语义分割训练(https://openaccess.thecvf.com/content_CVPR_2020/papers/Fan_Camouflaged_Object_Detection_CVPR_2020_paper.pdf),

训练时:输入图片RGB,输入target像素值只有0和255的单通道黑白图,loss为nn.BCEWithLogitsLoss(),训练时loss有在下降,打印求loss之前的网络输出结果看到,每个像素预测结果-5到5之间。这样的话sigmoid之后的值在0-1之间,target像素值只有0和1,所有训练时没有问题。

但测试时:网络的预测值全都接近0,都为10的-1,-2次方,导致sigmoid之后的值全在0.5左右,transforms.ToPILImage()之后像素值全为213左右。不明白为什么。对训练集进行测试也是这种情况。

问题相关代码,请勿粘贴截图

https://github.com/DengPingFan/SINet

运行结果及报错内容

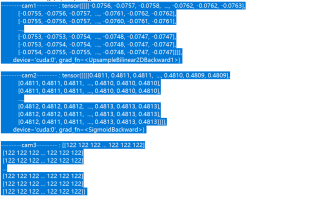

这是测试时打印的结果,cam1是网络预测的结果,cam2时sigmoid之后的结果,cam3是通过transforms.ToPILImage()将像素值调至0-255之后的结果

我的解答思路和尝试过的方法

怀疑是测试时对图片的预处理方式导致的,因此将测试时预处理方式调到和训练时相同,image=Image.open().convert('RGB')读取后,image = image.resize((512, 512), Image.BILINEAR),然后 transforms.ToTensor(), transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])]),都没有任何问题。

怀疑训练时多GPU并行运算导致?(瞎猜)但尝试单GPU后结果仍然不佳。

如果是图片前景面积过小导致类别不平衡,但训练时预测值也没问题。并且就算不平衡也不至于预测结果sigmoid之前全是0吧

我想要达到的结果

希望得到解答,找出可能错误的地方,不胜感谢

问题已解决

如果保存的模型是多GPU训练的,则load_state_dict()之前必须使用torch.nn.DataParallel()

来源https://www.cnblogs.com/tofengz/p/13546902.html#_label5

“踩坑记”

感觉是你的标注或者类别数目设置有问题吧。正常情况下,分割网络的标注文件的像素值,一般是0为背景类,前景按1,2,3,4递增表示不同的类别,255在很多分割网络里面表示不训练的类别,当然,我没细看你用的代码,有可能是有些网络设置就是0为背景类,前景类按255,254,253从高到低标注下来的。如果是前者的话,就是你的标注错误,你应该将你的target变成0和1而不是0和255,如果是后者那么你的标注就是正确的,那就是其他的问题

比较好的建议就是先跑作者用的数据集,能正确跑起来之后再换你自己的数据集