怎么加载从huggingface拉下来的模型代码

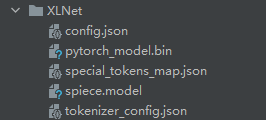

这是我从huggingface上保存下来的预训练好的model和tokenizer,代码如下

from transformers import XLNetTokenizer, XLNetForSequenceClassification

tokenizer = XLNetTokenizer.from_pretrained("xlnet-base-cased")

model = TFXLNetForSequenceClassification.from_pretrained("xlnet-base-cased")

model.save_pretrained("XLNet")

tokenizer.save_pretrained("XLNet")

现在我保存好了,下次使用的时候怎么加载model呢?全是bin,和json的,不知道怎么加载。只知道torch.load()加载pth的文件,没见过这些啊

首先huggingface上的预训练模型都是有示例代码的,博主贴的四行代码的中的前两行会检查你本地有没有XLNet这个模型,若没有的话就会从huggingface上下载相应的模型到一个指定的目录下去,然后加载使用,而你后两句代码相当于又保存了一遍模型,但这没关系,你可以直接使用你后面保存的模型。这个模型中的json文件,有一些是XLNet的配置文件,而那个.bin文件才是保存的模型,至于如何加载,人家官方提供了加载示例的。

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("xlnet-base-cased")

model = AutoModelForCausalLM.from_pretrained("xlnet-base-cased")

其实用你的第一行和第二行代码也行,但是在from_pretrained中指定一下你本地保存模型的路径就可以,然后就可以使用tokenizer和model去做接下来的事情了。

import wget

from fasttext import load_model

wget.download("https://dl.fbaipublicfiles.com/fasttext/supervised-models/amazon_review_polarity.bin", 'model.bin')

model = load_model("model.bin")

如果报错:

请按照下列步骤安装最新版本的fasttext(0.9.2):

git clone https://github.com/facebookresearch/fastText.git

cd fastText

pip install .

然后尝试执行你的代码