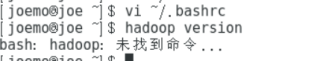

搭建hadoop集群的配置环境那一步, Hadoop version 反馈是 命令找不到,不是 环境的问题,和文件包的问题

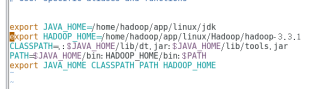

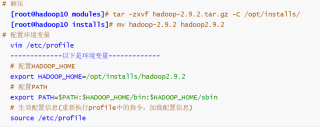

在网上找到的答案差不多都是环境没配或者环境没配好,反复调整后我确定没有问题下图是我的配置

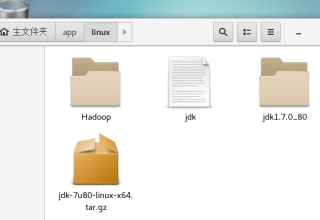

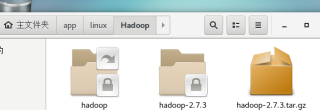

然后我感觉是安装包的问题,因为在tar zxvf 命令后出现了归档错误,于是我下了另外一个版本 没在出现归档错误 但是

仍然 是 hadoop version

----------Hadoop 命令没有

运行结果及报错内容

麻烦各位

给我看看 190507645@qq.com是我的邮箱

source 一下修改的profile,如果不行就去hadoop的bin目录下看文件的权限ls -l 看bin下面的文件是否具有执行权限x

HADOOP_HOME前面没写$符号啊,系统就找不到你的hadoop位置,加上$重新source配置文件,在尝试一遍,

若有用,望采纳

如上述回答,HADOOP_HOME变量少了个$

同时对于您这个hadoop搭建个人有几点建议哈,说的不对请多多指教。

- 不要将组件安装在home目录下

- 环境变量配置问题,在大数据组件中对于环境变量的配置是非常多的,需要有一个同一的规范,才能够合理得管理。由您的命令行可以看出,您重复了两次export HADOOP_HOME

- 看到您这边还是用jdk7以及hadoop2.7,不知道是您公司用的这个版本还是自学使用的这个版本,如果是公司使用的那无可厚非。如果是自学的话,那建议您使用jdk8以及hadoop3相关技术栈呢.

- 最后,我也做过相关组件的配置安装工作,如果您觉得有用的话,可以参考一下:hdfs集群安装(单namenode和HA模式)_从大数据到人工智能的博客-CSDN博客 单namenode节点准备文件下载:jdk-8u241-linux-x64.tar.gzhadoop-3.2.0.tar.gz节点安排:hadoop1 → 从节点hadoop2 → 主节点首先确保hadoop1能够免密登录hadoop1以及hadoop2将文件下载到/data目录下,并解压、建立软连接,最终状态如下:修改配置hadoop相关配置修改core-site.xml<configuration><property>

https://lrting-top.blog.csdn.net/article/details/120424314

不成