请教爬虫报错Nginx forbidden

对网站 http://www.tmsf.com/newhouse/ 爬虫报错

代码:

import requests

url = 'http://www.tmsf.com/newhouse/'

head = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.81 Safari/537.36'}

res = requests.get(url, headers=head)

print(res.text)

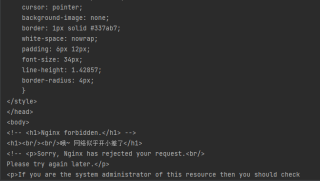

报错:

url改成 http://www.tmsf.com/ 就OK

请懂的专家帮忙看下

一是网址写错了,将鼠标放到新房链接图片上就可以看到正确链接,即:http://www.tmsf.com/hzweb/newhouse/

二是在请求头里要添加cookie。

这个应该是你爬取速度太快,被网站视为非人为操作而导致反爬,限制你访问了,建议用代理ip试试

这个网站我直接访问都进不去

确认一下是不是网址填错了

尝试改为http://www.tmsf.com/hzweb/newhouse/有帮助望采纳~