一个关于off policy的问题

我想要知道这里"重复"的整个过程,到底是怎么个重复法 要特别详细的说明

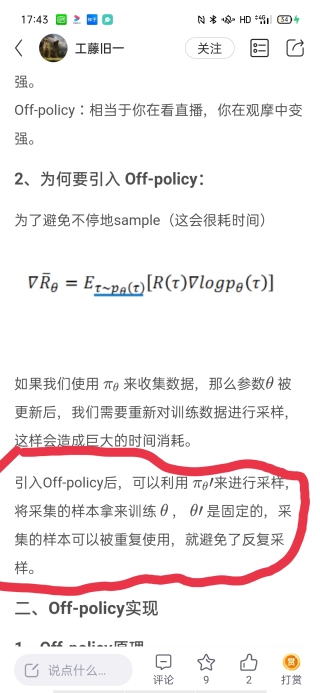

这是我今天看到的文,你也可以看看

我的理解,类似于DQN中的经验池(experience replay buffer)

behavior policy采样得到的结果记录到经验池中

在更新target policy的时候在经验池进行随机采样,这样就实现了样本的重复利用

而这时候target policy和behavior policy对应的参数不同,因此可以引入importance sampling ratio纠正偏差