spark整合每天的发电量

有人知道怎么用spark streaming处理一个数据,原始数据是每隔3分钟的时间戳和发电量,要把它整合成一天的发电量,总共有30多天的

import time

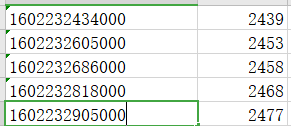

data = [

[1602232434000,2439],

[1602232605000,2453],

[1602232686000,2458],

[1602262818000,2468],

[1602262905000,2477],

]

d = {}

for t,v in data:

timeArray = time.localtime(t//1000)

otherStyleTime = time.strftime("%Y-%m-%d", timeArray)

d[otherStyleTime] = d.get(otherStyleTime,0) + v

print(d)时间戳转成日期求和啊

您好,我是有问必答小助手,你的问题已经有小伙伴为您解答了问题,您看下是否解决了您的问题,可以追评进行沟通哦~

如果有您比较满意的答案 / 帮您提供解决思路的答案,可以点击【采纳】按钮,给回答的小伙伴一些鼓励哦~~

ps:问答VIP仅需29元,即可享受5次/月 有问必答服务,了解详情>>>https://vip.csdn.net/askvip?utm_source=1146287632

非常感谢您使用有问必答服务,为了后续更快速的帮您解决问题,现诚邀您参与有问必答体验反馈。您的建议将会运用到我们的产品优化中,希望能得到您的支持与协助!

速戳参与调研>>>https://t.csdnimg.cn/Kf0y