kafka数据积压,不知道哪里错了

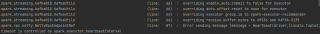

应该是sparkstreaming对接kafka的时候出现数据积压的问题,报错如下:

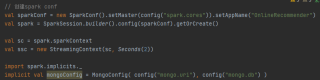

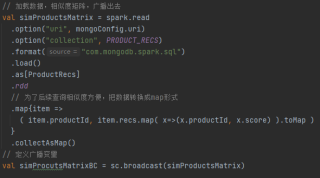

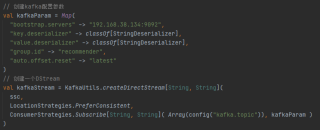

部分代码:

试过手动配置offsets,还是报错

val offsets = collection.Map[TopicPartition, Long] {

new TopicPartition(“recommender”, 0.toInt) -> 21

}

有没有大佬能解决的!!卡了好久了

好像是数据库自动提交设置为假了,有没有手动commit呢?注意查看一下参数。。

您好,我是有问必答小助手,你的问题已经有小伙伴为您解答了问题,您看下是否解决了您的问题,可以追评进行沟通哦~

如果有您比较满意的答案 / 帮您提供解决思路的答案,可以点击【采纳】按钮,给回答的小伙伴一些鼓励哦~~

ps:问答VIP仅需29元,即可享受5次/月 有问必答服务,了解详情>>>https://vip.csdn.net/askvip?utm_source=1146287632

非常感谢您使用有问必答服务,为了后续更快速的帮您解决问题,现诚邀您参与有问必答体验反馈。您的建议将会运用到我们的产品优化中,希望能得到您的支持与协助!

速戳参与调研>>>https://t.csdnimg.cn/Kf0y