ubuntu spark-standalone 运行spark-shell问题

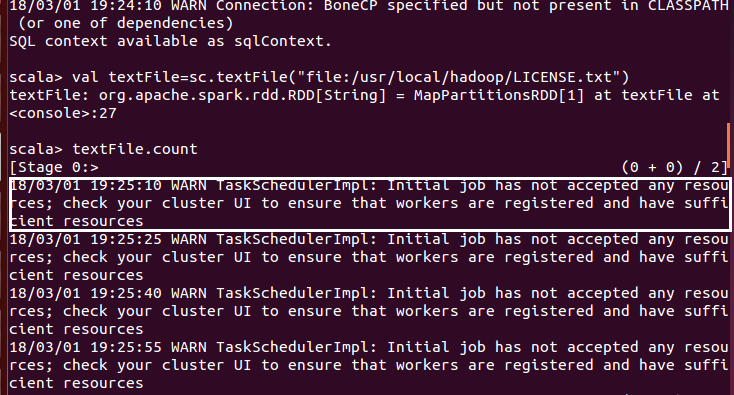

在spark-standalone下运行spark-shell,出现以下问题:

线程像是一直阻塞在运行的某个位置

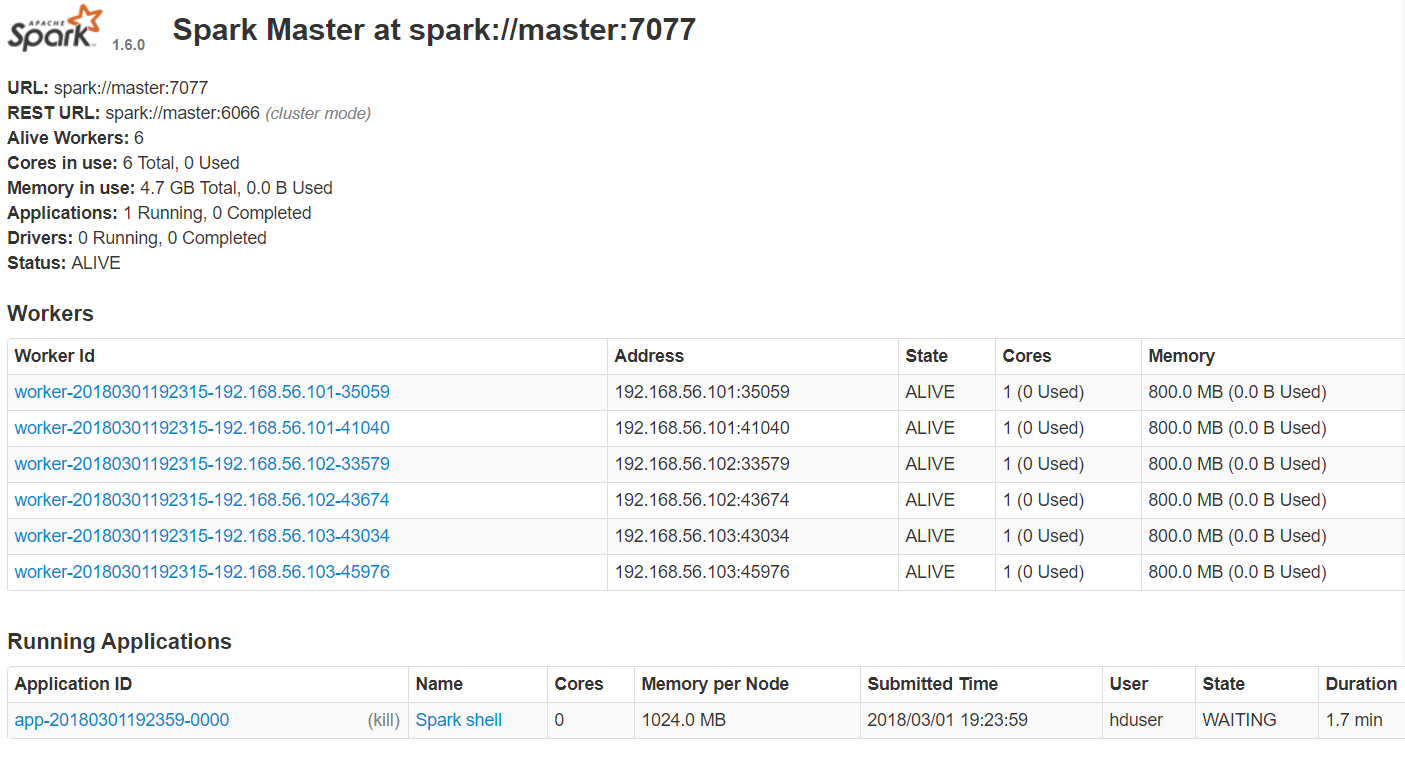

然后是Spark-master的截图

1、spark版本与Scala版本没有任何问题!

2、内存没有问题!

3、跟帖或者百度水贴误回(要搜索百度结果不如Google或Github,谢谢)

线程程序错了,你可以修改一下

Node的memory给予的内存空间少于了当前Applicaiton所需求的内存总量引起的,正确的做法,1、修改Application运行需要的内存,改小一点;2、修改

每个节点能提供的memory值,将800M改成1024M