hadoop start-all.sh问题

Hadoop 版本:hadoop-2.6.5

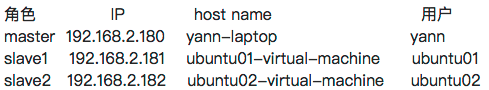

环境:

HODOOP_HOME 目录也不同:都在各自用户的目录下

e.g:

/home/yann/hadoop

/home/ubuntu01/hadoop

/home/ubuntu02/hadoop

当我在启动的时候start-all.sh

提示我如下错误:

yann@yann-laptop:~/develop/tool/hadoop-2.6.5/sbin$ ./start-all.sh

This script is Deprecated. Instead use start-dfs.sh and start-yarn.sh

Starting namenodes on [yann-laptop]

yann-laptop: namenode running as process 7041. Stop it first.

yann@ubuntu01-virtual-machine's password: The authenticity of host 'ubuntu02-virtual-machine (192.168.2.182)' can't be established.

ECDSA key fingerprint is 57:ee:92:a8:85:85:ef:16:26:a3:b7:1d:54:77:19:18.

Are you sure you want to continue connecting (yes/no)?

hadoop/etc/hadoop/slaves:

ubuntu01-virtual-machine

ubuntu02-virtual-machine

SSH公钥已经配置好:

ssh-rsa XXXXX......XXXXXX yann@yann-laptop

ssh-rsa XXXXX......XXXXXX ubuntu01@ubuntu01-virtual-machine

ssh-rsa XXXXX......XXXXXX ubuntu02@ubuntu02-virtual-machine

从提示来看它使用了yann去连接ubuntu01-virtual-machine。

请问这种情况如何配置?或者这种配置不提倡?

(1)主从机器不同的用户名

(当我把slaves文件改成 ubuntu01@ubuntu01-virtual-machine , 以上问题没有了,随之而来的是,它在我的ubuntu01这台机子上区找/home/yann/hadoop这个目录,当然没有,所以报了目录找不到,也就是下面第二点是否可行)

(2)hadoop安装目录不同 (貌似看到很多朋友把主从机器上的hadoop都是装在/usr/下)

楼主有没有配置master上的/etc/hadoop/slaves文件 每个slave占一行

我是使用start -dfs.sh(我的是2.7)

你最好还是使用相同的用户将hadoop放在相同目录下,三台主机配置免密码登录,配置的时候也只要配置一个,其他都copy就好了,也省事