深度学习用python构建感知器代码问题

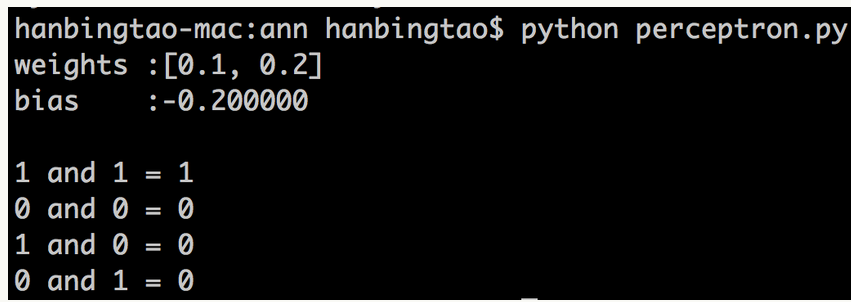

结果应该是图中的,可是我的结果都是0,不知道哪里错了,求各位大神帮忙啊

from functools import reduce

def f(t):

return t[0] * t[1]

class Perceptron(object):

def init(self,input_num,activator):

''' 初始化感知器,设置输入参数的个数,以及激活函数,激活函数的类型为double->double'''

self.activator = activator

self.weights = [0.0 for _ in range(input_num)]

# 权重向量初始化为0

self.bias = 0.0

# 偏置项初始化为0

def __str__(self):

'''

打印学习道德权重、偏置项

'''

print('weithts\t:',list(self.weights))

return 'bias\t:%f\n' % (self.bias)

def perdict(self,input_vec):

'''

输入向量,输出感知器的计算结果

'''

# 把input_vec[x1,x2,x3...]和weights[w1,w2,w3...]打包在一起

# 变成[(x1,w1),(x2,w2),...]

# 然后利用map函数计算[1*w1,x2*w2,x3*w3]

# 最后利用reduce求和

L = map(f, zip(input_vec, self.weights))

return self.activator(reduce(lambda a,b:a+b,L,0.0)+self.bias)

def train(self,input_vecs,labels,iteration,rate):

'''

输入训练数据:一组向量、与每个向量对应的label;以及训练轮数、学习率

'''

for i in range(iteration):

self._one_iteration(input_vecs,labels,rate)

def _one_iteration(self,input_vecs,labels,rate):

'''

一次迭代,把所有的训练数据过一遍

'''

#把输入和输出打包在一起,成为样本的列表[(input_vec,label),...]

#而每个训练样本是(input_vec,label)

samples = zip(input_vecs,labels)

#对每个样本,按照感知器规则更新权重

for (input_vec,label) in samples:

#计算感知器在当前权重下的输出

output = self.perdict(input_vec)

#更新权重

self._update_weights(input_vec,output,label,rate)

def _update_weights(self,input_vec,output,label,rate):

'''

按照感知器规则更新权重

'''

# 把input_vec[x1,x2,x3...]和weights[w1,w2,w3...]打包在一起

# 变成[(x1,w1),(x2,w2),...]

#然后利用感知器规则更新权重

def k(t):

return t[1] + rate * delta * t[0]

delta = label - output

self.weights = map(k,zip(input_vec,self.weights))

#更新bias

self.bias += rate*delta

def m(x):

'''

定义激活函数m

'''

return 1 if x>0 else 0

def get_training_dataset():

'''

基于and真值表构建训练数据

'''

#构建训练数据

#输入向量列表

input_vecs = [[1,1],[0,0],[1,0],[0,1]]

#期望的输出列表,注意要与输入一一对应

#[1,1]->1, [0,0]->0, [1,0]->0, [0,1]->0

labels = [1,0,0,0]

return input_vecs,labels

def train_and_perceptron():

'''

使用and真值表训练感知器

'''

#创建感知器,输入参数个数为2(因为and是二元函数),激活函数为m

p = Perceptron(2,m)

#训练,迭代10轮,学习速率为0.1

input_vecs,labels = get_training_dataset()

p.train(input_vecs,labels,10,0.1)

#返回训练好的感知器

return p

if name == '__main__':

#训练and感知器

and_perceptron = train_and_perceptron()

#打印训练获得的权重

print(and_perceptron)

#测试

print('1 and 1 = %d' % and_perceptron.perdict([1,1]))

print('0 and 0 = %d' % and_perceptron.perdict([0,0]))

print('1 and 0 = %d' % and_perceptron.perdict([1,0]))

print('0 and 1 = %d' % and_perceptron.perdict([0,1]))

看这个 https://github.com/hanbt/learn_dl/blob/master/perceptron.py

```python #你的代码改成这样可以正确执行@牧飞#

#!/usr/local/bin/python2.7

-*- coding: UTF-8 -*-

moofei,mufei, 牧飞

from functools import reduce

def f(t):

return t[0] * t[1]

class Perceptron(object):

def init(self,input_num,activator):

''' 初始化感知器,设置输入参数的个数,以及激活函数,激活函数的类型为double->double'''

self.activator = activator

self.weights = [0.0 for _ in range(input_num)]

# 权重向量初始化为0

self.bias = 0.0

# 偏置项初始化为0

def str(self):

'''

打印学习道德权重、偏置项

'''

print('weithts\t:',list(self.weights))

return 'bias\t:%f\n' % (self.bias)

def perdict(self,input_vec):

'''

输入向量,输出感知器的计算结果

'''

# 把input_vec[x1,x2,x3...]和weights[w1,w2,w3...]打包在一起

# 变成[(x1,w1),(x2,w2),...]

# 然后利用map函数计算[1*w1,x2*w2,x3*w3]

# 最后利用reduce求和

L = map(f, zip(input_vec, self.weights))

return self.activator(reduce(lambda a,b:a+b,L,0.0)+self.bias)

def train(self,input_vecs,labels,iteration,rate):

'''

输入训练数据:一组向量、与每个向量对应的label;以及训练轮数、学习率

'''

for i in range(iteration):

self._one_iteration(input_vecs,labels,rate)

def _one_iteration(self,input_vecs,labels,rate):

'''

一次迭代,把所有的训练数据过一遍

'''

#把输入和输出打包在一起,成为样本的列表[(input_vec,label),...]

#而每个训练样本是(input_vec,label)

samples = zip(input_vecs,labels)

#对每个样本,按照感知器规则更新权重

for (input_vec,label) in samples:

#计算感知器在当前权重下的输出

output = self.perdict(input_vec)

#更新权重

self._update_weights(input_vec,output,label,rate)

def _update_weights(self,input_vec,output,label,rate):

'''

按照感知器规则更新权重

'''

# 把input_vec[x1,x2,x3...]和weights[w1,w2,w3...]打包在一起

# 变成[(x1,w1),(x2,w2),...]

#然后利用感知器规则更新权重

def k(t):

return t[1] + rate * delta * t[0]

delta = label - output

self.weights = map(k,zip(input_vec,self.weights))

#更新bias

self.bias += rate*delta

def m(x):

'''

定义激活函数m

'''

return 1 if x>0 else 0

def get_training_dataset():

'''

基于and真值表构建训练数据

'''

#构建训练数据

#输入向量列表

input_vecs = [[1,1],[0,0],[1,0],[0,1]]

#期望的输出列表,注意要与输入一一对应

#[1,1]->1, [0,0]->0, [1,0]->0, [0,1]->0

labels = [1,0,0,0]

return input_vecs,labels

def train_and_perceptron():

'''

使用and真值表训练感知器

'''

#创建感知器,输入参数个数为2(因为and是二元函数),激活函数为m

p = Perceptron(2,m)

#训练,迭代10轮,学习速率为0.1

input_vecs,labels = get_training_dataset()

p.train(input_vecs,labels,10,0.1)

#返回训练好的感知器

return p

if name == '__main__':

#训练and感知器

and_perceptron = train_and_perceptron()

#打印训练获得的权重

print(and_perceptron)

#测试

print('1 and 1 = %d' % and_perceptron.perdict([1,1]))

print('0 and 0 = %d' % and_perceptron.perdict([0,0]))

print('1 and 0 = %d' % and_perceptron.perdict([1,0]))

print('0 and 1 = %d' % and_perceptron.perdict([0,1]))