Spark 中core没有分配

刚学习Hadoop+Spark

这是在virtualBox中建立的master->(slave1, slave2)集群

我通过

spark-shell --executor-memory 512m --master spark://master:7077

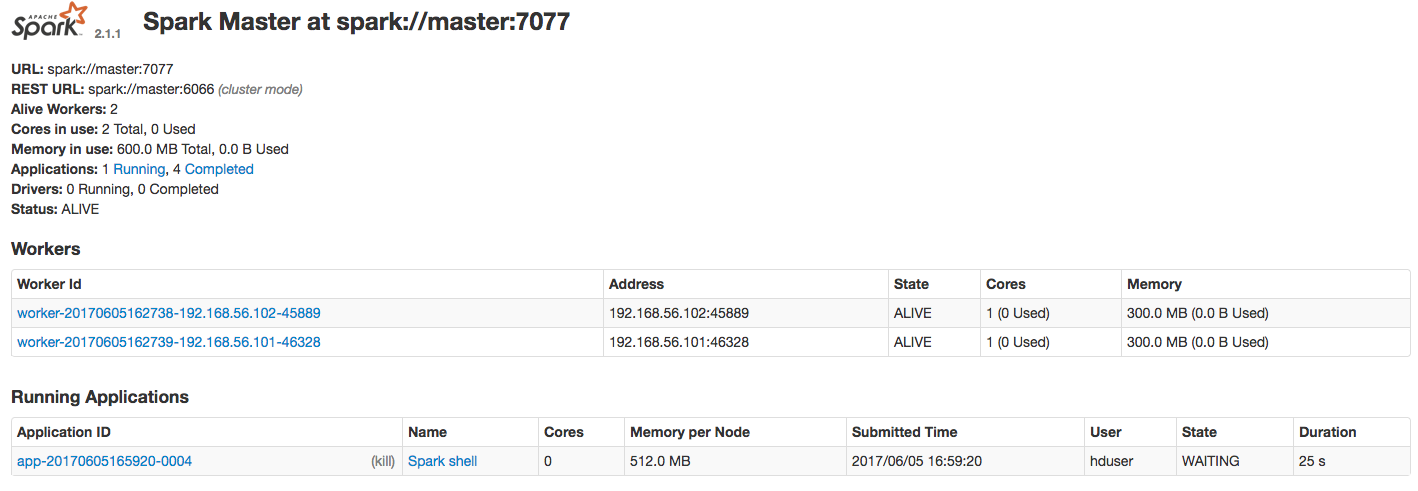

打开spark,然后发现,在UI中显示的状态是Waiting

我的spark-env.sh配置如下:

export SPARK_MASTER_IP=master

export SPARK_WORKER_CORES=1

export SPARK_WORKER_MEMORY=300m

export SPARK_EXECUTOR_INSTANCES=1

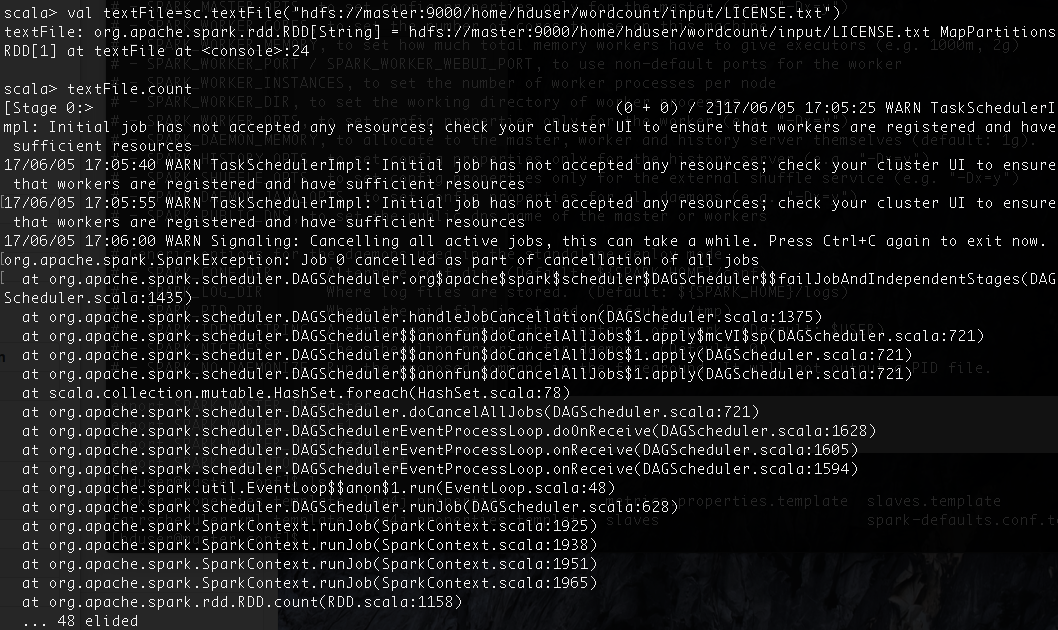

然后在scala中执行:

val textFile=sc.textFile("hdfs://master:9000/home/hduser/wordcount/input/LICENSE.txt")

textFile.count

出现如下错误

spark-shell --executor-memory 512m --master spark://master:7077

———————————

/\

|

|

|

512M太大了,你每个节点才300M,分不出来512M per Node