python+scrapy+selenium爬虫超时和连接被拒绝问题

在使用爬虫抓取 网站的时候,启动了多个进程,运行一段时间后有的进程会无缘无故的停止,,,,还经常会出现超时,,,,还有一个连接被拒绝的错误,,,请教大神这些问题产生的原因有哪些,,,怎么解决的.。。。。

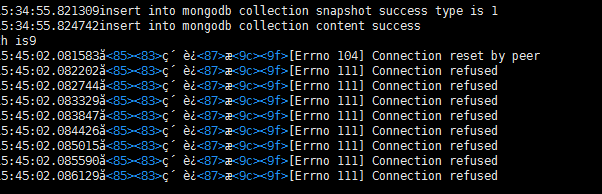

附连接拒绝的错误

一个是爬虫的个数,可能被服务器判断出在扒取数据了,还有就是同一个IP访问过多,

所以拒绝你的连接。

一个是降低扒取的频率,还有就是增加proxy代理,通过不同的IP爬取网站

目标网址,可能认出来了,这是个反爬

啥都不是,你是不是用了代理ip?免费的话绝大多数,几乎都不可用,你切换自己的ip试一下?

加sleep,加retry,避免被服务器的反ddos拦截掉。

做法参考:https://stackoverflow.com/questions/20164467/connection-refused-when-using-scrapy-with-selenium

多组user-agent随机换,换不同的ip,换x-forward-for,伪装自身为代理,让服务器不认为你是爬虫。

看下是不是内存泄漏或者什么原因随机造成服务器挂掉,java -jar selenium-server-standalone-<version-number>.jar 重启下selenium-server