中国天气网数据如何爬取

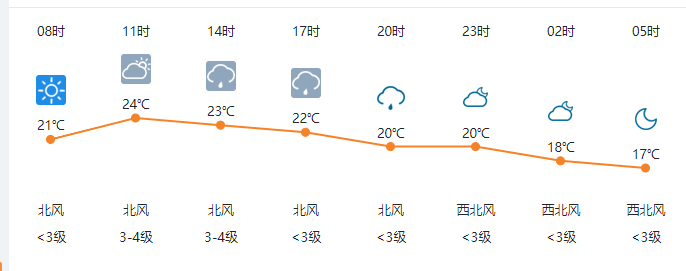

大佬们好,我想爬取图片中的每日实时气温,比如08时21度,北风等,该如何做:

import requests

from bs4 import BeautifulSoup

from pyecharts import Bar

ALL_DATA = []

def send_parse_urls(start_urls):

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.122 Safari/537.36"

}

for start_url in start_urls:

response = requests.get(start_url,headers=headers)

# 编码问题的解决

response = response.text.encode("raw_unicode_escape").decode("utf-8")

soup = BeautifulSoup(response,"html5lib") #lxml解析器:性能比较好,html5lib:适合页面结构比较混乱的

div_tatall = soup.find("div",class_="conMidtab") #find() 找符合要求的第一个元素

tables = div_tatall.find_all("table") #find_all() 找到符合要求的所有元素的列表

for table in tables:

trs = table.find_all("tr")

info_trs = trs[2:]

for index,info_tr in enumerate(info_trs): # 枚举函数,可以获得索引

# print(index,info_tr)

# print("="*30)

city_td = info_tr.find_all("td")[0]

temp_td = info_tr.find_all("td")[6]

# if的判断的index的特殊情况应该在一般情况的后面,把之前的数据覆盖

if index==0:

city_td = info_tr.find_all("td")[1]

temp_td = info_tr.find_all("td")[7]

city=list(city_td.stripped_strings)[0]

temp=list(temp_td.stripped_strings)[0]

ALL_DATA.append({"city":city,"temp":temp})

return ALL_DATA

def get_start_urls():

start_urls = [

"http://www.weather.com.cn/textFC/hb.shtml",

"http://www.weather.com.cn/textFC/db.shtml",

"http://www.weather.com.cn/textFC/hd.shtml",

"http://www.weather.com.cn/textFC/hz.shtml",

"http://www.weather.com.cn/textFC/hn.shtml",

"http://www.weather.com.cn/textFC/xb.shtml",

"http://www.weather.com.cn/textFC/xn.shtml",

"http://www.weather.com.cn/textFC/gat.shtml",

]

return start_urls

def main():

"""

主程序逻辑

展示全国实时温度最低的十个城市气温排行榜的柱状图

"""

# 1 获取所有起始url

start_urls = get_start_urls()

# 2 发送请求获取响应、解析页面

data = send_parse_urls(start_urls)

# print(data)

# 4 数据可视化

#1排序

data.sort(key=lambda data:int(data["temp"]))

#2切片,选择出温度最低的十个城市和温度值

show_data = data[:10]

#3分出城市和温度

city = list(map(lambda data:data["city"],show_data))

temp = list(map(lambda data:int(data["temp"]),show_data))

#4创建柱状图、生成目标图

chart = Bar("中国最低气温排行榜") #需要安装pyechart模块

chart.add("",city,temp)

chart.render("tempture.html")

if __name__ == '__main__':

main()

https://www.cnblogs.com/Fuckyoumom/p/12770510.html

https://blog.csdn.net/Remote_Sensinger/article/details/122852175?spm=1001.2014.3001.5502

可以访问下我回答的这个博客

1.地理科学生态网

最近更新了全国30m分辨率数据1980-2020年连续年份土地利用数据,分类为一级分类(耕地林地草地水体建设用地未利用地等);据同学下载实验,和landsat数据进行了对比,发现精度还是不错的。

并且有各种地理科学数据,竟然发现了很多宝藏数据。比如道路网数据、NPP数据、土地利用数据(二级分类)、乡镇边界、NDVI数据、地铁站点、气象数据(降雨量、气温、蒸散量、辐射、湿度、日照时数、风速)、径流量数据、30米土地利用二级分类数据、12.5米高精度DEM高程、2020年行政区划、10、30米NDVI数据、30m精度NPP净初级生产力、夜间灯光数据、统计年鉴、道路网、水系、景区医院等poi、三级流域矢量边界、地质灾害分布数据、30m土壤理化性质数据集、30mGDP柵格数据、30m人口柵格数据、30m精度植被类型数据、30m精度连续年份土地利用数据、GPP初级生产力数据、农田作物类型分布数据、自然保护区分布数据、高精度遥感影像数据、1:10万沙漠沙地分布矢量数据、蒸散发数据、降雨量气温蒸发数据、地表径流量、水汽压、土壤侵蚀数据等等!

2.地理空间数据云

(1)2000年全球土地覆盖计划(GLC2000)

(2)欧空局全球陆地覆盖数据(ESA GlobCover)

3.地理遥感生态网

网站地址www.gisrs.cn

该网站同样更新了很多有关地理的数据,30米土地利用二级分类数据、12.5米高精度DEM高程、2020年行政区划珍贵的乡镇边界、村边界、气象数据(降雨量、气温)、径流量数据等。